2013년 8월 30일 금요일

HP 교육1

10월29일

이현철

vsky123$@daum.net

http://labs.usa.hp.com/

6000원

1층국수

서초오피스텔 지하1층

뚜레쥬르

장수삼계탕

현경

1. nPar vPar

2. Integrity VM ( Itanium 2 기반 )

1. VSE virtual server environment

2. addressing HW

3. nPars (cell board 시퓨메몰 , IO chassis SBA LBA PCI slot)

최대 rx7000 2장 8000 4장 superdome 16장

4. ignite-ux 배포서버 - 골드이미지 golden image

5. vPar (nPar 상에서 core 단위로 자원할당)

- nPar 상의 core 를 동적 할당 제거가능.

- ILM /CLM - 퍼포먼스관련됨.

CLM (Cell Local Memory ) - 같은셀보드가아니라면 성능이 느림

ILM ( Inter leaved Memory) 스트라이프 - 속도 평준화

NUMA 구조 (cell borad 여러장의로 H/w 구성)

6. vPar 생성

7. vpmon (virtual partition monitor - 각 vpar 를 부팅)

2권

8. integrity VM V4.3 (이전버전 - itanium 기반 쿼드듀얼싱글코어 지원),

V6.1 (11.31.1203에서 추가 - 쿼드코어서버전용)

- VM 6.1 - 한서버 안에서 vPar + VM 동시에 지원.

예) cpu 8 core 로 cpu2개짜리 vpar2개생성 나머지 cpu4개로 VM 8대생성가능 (%단위로할당)

- VM 4.3 - vpar 상에서 VM 생성이안됨.

9. preParing HW

- DISK (VM host 상의 file , lvol - 파티션 , disk , lun )할당 -성능에밀접

10. VM 생성 - 스크립트화

11 VM 관리 메몰최소2기가

12 VM 이동 (SAN환경에서가능)

13 ServiceGuard with VM (SAN환경에서가능)

부록A 콘솔

부록B NPIV

FC HBA - WWPN (64bit) -> 최근 가상화 시켜 여러개의 nport ID 부여가능(가상IP)

==========================

1.

physical disk 의 약점 : random IO 취약 (4kb BLOCK IO/sec) : 8MB

Sequencial IO : 150Mb

가상화시 switching 관련비용발생

1-3

비용절감

온라인셀보드장착시퓨메몰증감가능

비용,성능,안정성

Tiered storage (한스토리지안에 여러종류 디스크장착 ssd, sas, sata)

1-4 nPar 활용

npar -> hp-UX 사용

npar -> vpar -> os 설치 사용

npar -> os 설치(host) -> VM s/w -> vm 에 os 설치(guest)

Secure Resource Partitions (PRM)

One Os 안에서 자원관리

1-5

vpar only (processor based)

rp7400

rp5405

rp5470

npar and vpar

HP 9000 and superdome

superdome2

rp7400 ,rx7600 (2cell)

rp8400 , rx8600 (4cell)

VM

all Integrity server (itanium)

--------------BLADE system

1. blade Enclosure (c7000 - HH 16대 c3000 - HH8대

FH 8대 FH4대)

2. Onboard Administrator (OA) 2장 hot/stand by

ILO port 1개로 각 blade 서버의 mp 로연결됨.

전력 냉각 MPIP 설정 inter conerctor(SW) ip설정

3. blade server (x86, integrity )

4. power supply (최대6개)

5. active cooler (최대10개)

4,5는 full 로안할시 정해진위치가있당

------------HP-ux 용 blade 서버

BL860 (dual core) , BL860 i2 (quad core) : blade server 1장

BL870 (dual core) , BL870 i2 (quad core) : blade server 2장

BL890 i2 (quad core) : blade server 4장

i2 보델부터는 blade foundation (BL 860 i2)를 추가합체가능함.

ignite-ux 서버만들기

1.hp-ux 설치

59.29.225.0 (끝자리 222 3 4 7 8 9 30 ) rx222 root/hp

MP 59.29.224.0 Admin/Admin..

59.22.225.228

ignite server ip 59.29.225.10

2. mp 접속

vfp

^b - cm - pc - off - y

pc - on - y

엔트리이상장비는 pe

rs - y

co

bootmanager 파란색 에서 멈춰

boot configration 선택 - boot from file

(dvd tape lan )

load file core lan gb A

select db-profile

(direct boot profile) -> 직접아이피설정,서버에정보없어도됨

-none - 선택 - -> 서버에서 아이피받기, 서버에bootptab있어야됨

os 버전선택

iinstall (os설치시커널)

Install HP-UX - advenced - ok - lan0

server name & ip setting

지난세팅사용 no

configurations 에서 버전 선택

(백업본일때는 백업본들 이나옴 날짜별로선택)

environments 에서 os 버전선택

boe 기본적,글렌스라이센스없음

haoe 서비스가드 글렌스 PRM 라이센

vseoe vpar VM

dcoe 최상위버전 (data center operating environment)

(haoe vseoe 다 포함)

s/w 선택해줘야 설치됨.

dcoe 선택

root DISK 선택 - override setboot default 선택

file system - LVM

(VM file 을 disk 로쓰려면 whole disk with Vxfs로 해도된다)

software 텝

all

cde-english

cde-korean

ignite(OE) - 프로그램

ignite-UX-11-31(OE) - 배포이미지 (3버전다선택)

ISOIMAGE-ENH(OE) - 가상이미지지원

JAVAOOB(OE) - 자바환경설정,커널튜닝까지,바로실행가능

MemFS(OE) - 메모리를 잘라 file-system 구축

swapoff (11.31 에서는 swap를 online에서 해제가능)

(사용하지않을때만가능)

T1335DC (vPar S/W)

T2767CC (Integrity VM)

T8718AC (VM online migration 툴)

VMMGR(OE) - VM용 GUI툴 SMH에서 실행가능

System 텝

Time Zone KST-9

set root password

file system텝

additional Tasks

group parameters

LVM 1.0 , 2.2 (1.0 은 2T 이상안됨)

pht ext size 8 -> 64 (lvol 만들때 8은 512기가뿌니몬씀 64야 2T 씀)

modify

file system parameters

block size 변경가능

GO!

LV 만들고 usr ,opt 복사하고 sw 설치

리스토어시는 sw 설치안하고 복사

-----------------------------

1-6

Instant Capacity (icap)

미리장착된 cpu 필요할때 봉인해제

Temporary Instant Capacity

(몇일만쓸때) TiCAP

----------------

1-7

XBC - crossbar controller

Core IO - console

Each nPar Requires 최소조건

at lest one cell

core io

at lest one IO chassis

A boot LBA and boot device

1-8

vPar

- dedicated CPU RAM IO -공유안함

- 동적 cpu ram

cpu 최소 1개 , 2개이상권장

-----VM 실습서버

rx219 59.225.219

model - rx3600

hpvminfo - hpvm host

hpvmstatus

cpu는 % 할당 mem은 공유아님

(최소2기가할당해야되어 메모리가VM 갯수제한)

machinfo

itanium 2 -싱글

itanium 2 9100 9200 - 듀얼

itanium 2 9300 - 쿼드코어

mpsched -S

locality domain - 시퓨장착된 보드갯수

processor - 코어수

[] 당 코어로 보면됨.

Socket 0 : [0] [2]

Socket 3 : [4] [6]

하이퍼스레드 켜기

kctune lcpu_attr=1

Socket 0 : [0 1] [2 3]

Socket 3 : [4 5] [6 7]

VM에서는 하이퍼스레드가 불안정하니쓰지말것

hpvmstatus -VP vm190 |more

vm 부팅시 control B 누르면 부팅취소될수 있으니 주의

1-9

vpar 에서 VM 안됨.

1-10

PRM - 최소자원보장 (Process Resource manager)

1-11

SIM - SMH

SIM - 서버 스토리지 통합관리

1-12

WLM (work load manager)

응답시간 처리량 목표지정

prm 구성 -실행 - 측정 - 피드백 -자동제어

유료

1-13

Global Workload Manager GWLM

멀티서버환경에서 사용

1-14 integrirty essentials capacity Advisor

예측해서 관리 - 유료

1-15 integrity essentials virtualization manager

통합 관리 - 유료

==== hp 문서사이트

http://docs.hp.com

http://59.29.224.173

2장 H/W address

npar - cell board 의 번호

vpar - LBA address

2-3

sx2000 sx1000 칩셋

cell-based server

(1000은 크로스바 1개에 2개 할당되어있고

2000은 셀1개에 크로스바가 여러개 할당되어있음

최적 셀 설치위치선정이 다름)

이웃 cell board

sx1000 02 13 46 57

sx2000 0123 4567

cell-board [ cpu mem cell-controller ]

IO [ sba(system bus adapter)-LBA(2 차IO)-pci_x_bus ]

IO 133Mhz x 64bit = 1.3Gbit (약1기가 바이트)

듀얼포트 스피드 다 누릴려면

133x 128bit 해서 2기가 된데다 pci-x-bus 에 1개만있어야됨.

olrad -q 로 max speed 체크 spd 현재속도

예) 8Gbps dual

8bit -> 1GB x2 = 2GB

이면 Max spd 266이상에 장착해야 잘됨

예전슈퍼돔 IO 가운데 4개가 고속슬롯임.

system backplane

crossbar switch 3개 (sx2000일때)

2-4

7천시리즈 셀보드 2개

2-5

8천시리즈 셀보드 4개

단 io 기본2개만 장착

확장IO 2개추가가능

SEU (Server Expansion Unit)

Complex

2-6

super dome 1

1cabinet 당 8celboard 최대 2cabinet

1cabinet 당 io 4개 장착

추가 IOX 는 별도캐비넷 필요 6개까지들어감

sx1000 칩셋

crossbar에 0 3 이 1포트 1 4 가 1포트 2개가 1개씩 할당.

2-7

npar

cell

IO

vpar

core

mem

LBA (I/O slot)

VM

vCPU (%할당)

mem (전용)

vdisk & vnet

물리자원 (공유 or 점유가능)

2-8 address type

HP-UX kernel - OS 관점

HP-UX slot - BOX 관점 (물리적위치)

Integrity firmware - Itanium CPU 관점 (EFI address=ACPI address)

2-9 legacy vs agile(좀더빠른) address

OS관점 주소공간

11.31에서 agile - san 환경-multipath커널레벨에서지원

OS에서 멀티패스에 로드벨런싱까지 제공

2-10 legacy

1/0/0/2/0

cell/SBA/LBA/device/function

sba-IO chassis (셀보드에 1대1이라 항상 0번 )

lba-2차IO (여러개) Local Bus Adapter

device-LBA 칩관점에서본 상대적 PCI 슬롯번호

2-11 legacy scsi

1/0/0/2/0/0.1.0

__________ . target . LUN ID

HBA H/W address

target - scsi-2 target 0~15 (7은card)

LUN이 0이면 스토리지디스크 X

=================

DATA IO 시 scsi protocol - 주종관계

initiator -> target

물리적계층 (pSCSI, SAS ,Fiber HBA)

2-12 FC hw address

1/0/2/1/0 .6.1.0 .0.0.1

--------Initiator

HBA HW

target

.6.1.0

SAN domain/area/port ID

domain (Switch ID)

area (맨마지막SAN스위치상 포트)

port (허브)

.0.0.1

Array LUN ID

(스토리지에서할당한 LUN ID)

스토리지 lun을 hp-ux 주소로해석

lun 생성시 2개 id부여 lun id -관리자 , wwid -storage 자체

10진수 lun id 2진수 14자리로 환산후

7bit 4bit 3bit 로 나눈후 10진수로 읽음

4bit target , 3 bit lun bit

예) lun8 번

00000000 / 0001 / 000 => 0.1.0

0 0.0.0

1 0.0.1

2 0.0.2

6 0.0.6

7 0.0.7

8 0.1.0

16 0.2.0

128 1.0.0

255 1.15.7

끝 3자리로 target 과 lun은 나오지만

controller는 알수없다 카드아닌 경로

1/0/2/1/0.6.1.0.0. 0.1

--------------- c#

.0.1 t#d#

6.1.0 은 SAN스위치의 스토리지와연결된 포트번호1

2-16 agile

16진수

2-17 FC lunpath

특정 lun 으로 가는경로

64bit

1/0/2/1/0.0x64bits.0x64bit

--------

HBA H/W address

0x64bits - WW port Name (LAN의MAC같은)

0x64bits - LUN address

2-18

1/0/2/1/0.0x500001fe15003112c.0x40010000000000

---------HBA

0x500001fe15003112c

array FC WWPN

0x40010000000000

4 lun TYPE

001 16진수 lun id -> 10진수변환

2-19

64000/0xfa00/0x4

virtual 기존 lun 멀티패스를 하나로 합친거

가상이기때문의의미없음.

legact - c_t_d - 경로에의해 이름부여

agile - persistent (dsf) 새롭게 검색되는 lun의 wwid마다

새이름 부여 (disk9,disk10) -경로바껴도 안바뀐다 (영구)

10월 30일

2-20

Ioscan –funC disk

Ioscan –funNCdisk (N:new name)

Ioscan –m dsf (m:mapping)

Device Special File

Ioscan –m hwpath

Lun H/W path (가상 LUN :발견된순서)

대표이름 무의미

Lunpath H/W (port num)

Lehacy H/W path (c_t_d_)

ioscan -m lun

smh (sam 후속 text,web버전)

Disks and File -> Disks 에서 모든정보확인가능

2-21

Legacy H/W

one per PATH

port,lun

Agile LUN H/W path

one per LUN

가상

Agile lunpath H/W path

one per PATH

port 정보 미포함.

WWN,LUN

2-23

vpar 생성하기

1. npar 생성 -> os 설치 , vpar s/w 설치

15. npar 상태에서 ioscan 결과저장

(vpar상태가되면 전체 npar정보볼수없다)

2. vpar 생성 (cpu core,mem ,LBA(IO) 할당)

3. 부팅모드를 vpar로 전환 (npar os가 vpar의 os로 전환)

(첫os만 전환가능 나머진 따로설치)

4. 추가 vpar생성 (자원할당)

5. mp 접속 - co - npar 선택 - ctrl+a 단축키 :vpmon vpar0..순환

LVM version

lvmadm -t |moer

LVM v1.0 - pv 2T

LVM v2.x - pv 16T

LVM v1.0 일때 pe size 에 따른 pv 최대크기제한

pv= pe * max PE per PV(65000개)

=4mb 일때 *65000 = 250G (실제는 132G : pe 1 size에관리구조포함)

=8mb 512G

=16 1024G

=32 2048G

=64 2048G (추천)테이블이작아짐 포인터겟수줄어 32000개

2-26

cabinet - bay - chassis -slot

0-1-3-4

bay 앞0뒤1

chassis 왼1오3

slot 12개 0-11

2-28

olrad -q

2/0/1/1

cell/sba/lba/dev

2-29

EFI H/W address

1.processor-based

HP SBA/LBA/de/function.target.LUN

EFI ACPI(vendor,LBA)/pci(device/function)/SCSI(PUNtarget,LUN)/HD(PARTpartition,hex)

cell-based

HP Cell/........동일

EFI ACPI(vender,CellLBA).........동일

2-30

ACPI(HP,154_

1번cell

54 LBA

EFI SHELL에서

shell> info io 하면 슬롯알수있음

2-31

ioscan -e (show EFI address)

2-32

pdweb

Peripheral Device (주변장치)

2-34

integrity boot disk format

partition table

EFI system partition (part1) fat32

OS partition (part2) unix

Service partition (part3) fat32

Partition table

2-35

LAB 접속하기

http://labs.usa.hp.com

grp259user2 (3,4...) 난6번

factname2 (3,4...)

이번주까지만접속가능

group10 선택

mp 접속후

parstatus

co

machinfo

mpsched -S

smh -> peripheral device -> olrad

3

3-2

sd2

cell blade

cpu,mem,메자닌(mezzanine)카드-blade서버용pci카드,10g lan

mid plane

inter connector s/w

1 path thru - port 만

2 sw(ethernet,fc s/w)

crossbar

IO box

슈퍼돔1은 크로스바-셀-IO

슈퍼돔2는 셀블레이드-크로스바-IOBOX

3-3

mem

interleaved mem - access 속도가 평준화된 (raid01)

cell local - 특정 cell 에서 메모리를 잘라서 주는방식

(최고속도- cpu 와 같은 cell에서 할당

최악속도 - cpu와 다른 cell 에서 할당된 mem)

SLM 소켓로컬메모리

3-4

npar 내에서는 동일 cpu 사용

sx1000 npar 당 coreI/O 필요

sx2000 cell 당 coreI/O 필요

npar당 크로스바 통과횟수줄이는게 좋음

3-5

Interleaved mem vs Cell Local mem (ILM/CLM)

메모리구조예

npar cell 4장 각 64G 총 256일때

1. 256 모두 ILM (npar기본,첫구현방식) : 평준화된 속도

2. 각 cell 마다 32G를 CLM - 32x4 (총4개영역)

나머지 128은 ILM

성능관점에서 ILM/CLM 비율

=CLM 특성활용 잘하면 높게 아니면 낮게

=====

프로그램 실행시 data종류에따라 할당위치가달라짐

1. private data = CLM (실행시주어진시퓨의메몰CLM)

2. shared data = ILM

=====

CLM활용방법

1. npar생성시 ILM/CLM 양을결정(parmodify 로재조정가능 리붓)

2 vpar 생성시 ILM 기본할당 -지정하면 ILM

3. npar그대로 사용 -어플이 NUMA구조지원시(oralce)CLM활용

-JAVA(JVM,multi thread),SAP : mpsched 로 cpu 할당

mpshed -l [local domain Id]

=====

부팅 시 ILM생성 cache line (128byte) 메모리에서 cpu 가저가는 단위

로 스트라이핑 함.=속도 평준화

Dynamic Cell - 운영 중 cell 추가가능= CLM으로 추가됨.

11.11은 ILM만가능

3-6

first partition = genesis partition (1cell 1io box만 들어있음)

mp - cc 명령 (기존npar 모두 삭제 1st partition만만듬)

3-8

mp - bo 명령

npar 정보는 mp에 저장됨

stable data - npar,cell assign CLM 등

dynamic data

pratition config

리붓시 갱신됨.

3-10

mp - parperm npar관리권한부여

3-11 remote npar config

mp - parperm 다른 npar 관리권한

psrperm=unrestricted 되어있어야됨.

ip 통해서도 가능

so 로 passwd 설정

sa 로 Lan access 설정

3-12

parmgr

parcreate

parstatus

3-13

parmgr

smh 에서돌아감

3-15

parcreate

-c cell:celltype:use_on_next_boot:failure_usage:CLM

cell: cell num

celltype: 붙박이-ILM생성, 이동형 (floating)-CLM

next:y or n

fail: ri or float

-ri:base cell default (reactivate with interleaved mem )

-float: float cell default (CLM용으로활용)

CLM: % or G

-L CLM 할당 (둘다지정시 -c옵션의내용을설정)

3-16

parmodify

-a add

-m mod

-d del

-I change management tools ip

-r root cell (부팅시사용될셀우선순위)

3-17

remote parmodify

-h nparaddress (os Ip) -u id:pass (root)

-h MPaddress (MP) -g IPMIpassword (mp에서 so ,sa로설정)

3-19

npar reconfig

Cell status 가 boot is blocked (BIB) :vfp에서 확인

npar 변경시 MP 정책다운로드

shutdown -R now

reboot -R now

mp - RR 명령

BCH:Main Menu: RECONFIGRESET (PA-risc)

SHELL>reconfigreset (Integrity)

3-20 PA-RISC

BCH (boot rom firware)

pf PRI 2

pf HAA 1

pf ALT 0

0 = immediately to BCH

1 = try boot , fail to BCH

2 = try boot ,fail next PATH

3 = skip , next PATH

3-21

boot mode

# vparenv -m nPars (on HPUX)

- nPar 일때 부팅커널 호출 /stand/vmunix

- vPar 일때 /stand/vpmon 호출- 각 vpar 커널호출

MON> reboot nPars ( mp-co-ctrl+a change vpmon)

fs#:> vparconfig reboot nPars (EFI shell)

shell> parconfig nPars -n

shell> parconfig reset

shell> acpiconfig single-pci-domain (linux)

shell> acpiconfig windows (windows)

shell> acpiconfig default (hpux)

3-22

PDC (processor dependent code :boot rom)

-> ready to reconfig ?

-> Y: download partition profile to npar cell

-> cell POST

->Rendezvous (랑데뷰포인트) 에서 elect Monarch (대표 CPU선택)

-> PA-RISC일때 BCH ->ISL->HPUX

-> Integrity 일때 EFI -> ACPI -> OS boot loader ->boot mode npar?

ACPI (window 냐 hpux 냐)

3-24

parstatus

-A Free 자원

-C cell

-I IO chassis

-V verbose

-M machin readable

3-25

ToC to nPar

mp - cm - tc

(crash dump 뜬당)

lvlnboot -v

crashconf -v

top 하면 page size 나옴 보통 4kb

3-26

delete nPar

parremove -p num [-F (자기자신제거할때)]

3-28

dynamic nPar

unassigned cell

-parmodify -a ->

assigned cell

-parolrad -a ->

active cell

-parolrad -d ->

inacive cell

floating cell

parmodify -p 1 -a 1:floating:y::100%

parolrad -a 1

olrad -A -s 1

3-29

IO is not active atomatically

olrad -A -s 로 활성화

olrad -D -s 로 비활성화

3-31

floating cell

parmodify -p 1 -a 1:floating:y::100%

parolrad -a 1

olrad -A -s 1

3-33

hyper-threading

only 11.31

setboot -m on|off (변경시재부팅필요)

parmodify -p par_num -T y|n

shell> cpuconfig threads on|off

MON> threads on|off

======

processor set

cpu core를 그룹핑하여 process나 application(PRM) 에 할당가능

psrset

pset 0에 모든 코어가 소속

psrset -c cpu 번호

pset 0의 하이퍼스레딩 활성화 kctune lcpu_attr=1

psrset -t pset_id 번호 LCPU=ON|OFF

psrset -f -d all (모든 pset삭제)

10월31일

4-2

ignite-ux와 client 동일버전사용추천

4-5

set up IP

server

pa-risc /etc/opt/ignite/instl_boottab (mac불필요)

integrity /etc/bootptab (mac 필수)

target

pa-risc boot lan.ignite_setver_IP install

itanitum PXE boot

5-4

11.31 1203

vPar+VM = v 6.1

VSP - virtual server platform

5-7

vPar Database

/stand/vpdb (/stand/vpmon 이 5초간격 갱신함)

partition name

resource - cpu mem LBAs

boot devices - pri alt

boot option - auto|manual , search|nosearch

5-6

nPar

그룹된 cell

vPar

독립 cpu, mem

VM

가상화 cpu

독립 mem

가상 disk, net

물리장치 공유가능

5-9

AUTO 파일편집

mkboot -a " hpux /stand/vpmon -a " /dev/rdsk/c#t#d#

vpmon 의 -a 옵션은 모든 vpar 스타트 ( 없으면 아무스타트안함)

========ignite 일부파일만복구

gzip -dc file명 | tar -tvf -

gzip -dc file명 |tar -xvf - etc/hosts

ftp 파일전송시 문제

umask 변경 permission , 소유자 변경됨

rcp -rp (보안상금지)

scp -rp 파일명 서버IP:/dir

5-14 vPar version

v5.X

11.31 1203 v6.1

5-20

cpu 할당방법

-갯수만 (vpmon 이선택)

-특정시퓨지정

-특정셀에서갯수만 (recommand : 메모리같은셀에서할당됨)

5-22

mem ILM/CLM

interleaved , cell local

5-23

메모리할당단위 mem granularity

vparenv

5-24

dynamic mem

5-25

I/O - 리붓필요

자신의 LBAs 장치만보임

SBA도 할당가능( iobox)

최소 fc1 lan1필요

5-27

CLM

same crossbar (1 hop)

diff crossbar (2 hops)

ILM

LAB3

total ILM 6G

total CLM 2G

제약 1기가남기자(다음연습시사용)

vpar0 vpar1

BaseILM 2G 2G 5G

FloatILM 1G x

BaseCLM 0.5 1 2G

FloatCLM 0.5 x

total 4 3 7G

vparname vpar0 vpar1

-p name

boot disk 1/0/0/3/0.6.0 1/0/2/1/0.1.0.0.0.0.5

-a io:<path>:BOOT

Lan LBA 1/0/1/1/0/6/0 1/0/6/1/0/4/0

1/0/1/1/0/6/1 1/0/6/1/0/4/1

1/0/6/1/0/6/0

1/0/6/1/0/6/1

-a io:<cell.sba.lba>

other LBA 1/0/2/1/0 1/0/2/1/1

-a io:<cell.sba.lba>

cpu total 1 1

-a cpu::<total_cpus>

cpu min:max 1:4 1:4

-a cpu:::<min>:<max>

Base ILM (mb)

-a mem:<mem>

Float ILM

-a mem::<mem>:float

Base CLM (mb)

-a cell:cell:mem::amount

float CLM

-a cell:cell:mem::amount:float

ilm granularity

-g ilm:<granularity>:y 256 X

clm granularity

-g clm:<granularity>:y 128 X

6-2

vparcreate

-g memory_granularity ( first vPar Only : 변경안됨 )

-D databasename (default : /stand/vpdb)

-o boot opeion "-lq" -lm -is

6-3

total cpus (부팅시사용할 cpu 갯수 지 총갯수아님

min < total < max )

-a cpu::<num>

min,max

-a cpu:::<min>:<max>

cell local cpu

-a cpu:<cell_num>::cpu:<num>

specific

-a cpu:<cell.cpu_address>

<adress 할당시 /를 . 으로 바꿔써야함)

6-4

ILM

-a mem::<size>

CLM

-a cell:<cel_num>:mem::size

granularity (first vpar only)

-g ILM|CLM:<unit>[:y|n] (y|n intergrity only

write granularity to firmware)

1 /stand/vpdb (기본저장)

2 NVRAM 에 추가저장 (y 시 itanium 에서 필수지정)

예) vparcreate -p vpar0 -a mem::2038 -g ILM:512:y -g CLM:256:y

6-5

LBA

-a io:<hw_path>

SBA

-a io:<sba_hw_path>

boot dev

-a io:<boot_path>:BOOT|ALTBOOT|TAPE(tape는 pa-risc만)

6-11 AUTO edit

PA-RASC mkboot -a "hpux /stand/vpmon -a" /dev/rdsk/c#t#d#

Integrity mkboot -a "boot vpmon -a" /dev/rdsk/c#t#d#

vparrefiutil -u (update 새부팅디스크변경시마다반드시)

vparenv -m vPars (vparenv -m nPars)

6-12

PA

ISL> hpux /stand/vpmon -a

ISL> hpux /stand/vpmon -> MON>

IA

HPUX> boot vpmon -a

HPUX> boot vpmon -> MON>

6-13

readdb vpdb read

vparload vpar start

6-14

#vparenv -m vPars

SHELL> fs1:\efi\hpux\vparconfig reboot vPars

===

MEM granule size must match firmware

vparenv -g ILM:512 -g CLM:256

6-16

root disk 변경시

vparefiutil -u (Update EFI path )

안해서 부팅안될떄

MON> vparload -p vparname -E index

LAb4

vparcreate.txt

11월1일

7-3

change mem (floating)

7-4

vparstatus -A

남은 자원확인

7-5

cpu min max 변경 시 재부팅 필요

min max 내에선 동적변경가능

7-6

base mem :동적 추가가능하나 제거는 재부팅

float mem : 동적 추가 제거가능

7-8

vparmodify -B auto (vpmon -a 에 반응하여 부팅됨)

vparmodify -o "-lq"

7-11

vparreset -p vpar2 -t (system crash dump후 리붓)

vparreset -p vpar1 -h (halt vpar)

7-12

MON> reboot [nPar|vPar]

reconfig nPar (모든 vpar 다운후아래진행)

shutdown -Ry 0

7-13

monadmin -S off (vpar에서 다른 vpar 관리가능)

default OFF 상태

7-19

PA

# vparboot -p vpar2 -I 10.10.25.2,/opt/ignite/boot/R...../WINSTALL

EFI

# vparboot -p vpar2 -I

(bootp 이용하기때문에 경로x)

7-20

EFI eirect boot for vpar

vparboot -p vpar1 -I -s <igniteIP> -c <clientip>

-g <gateway> -m <submnet> -b /opt/ignite/boot/nbp.efi

OR

vpardbprofile -d profilename -s ip -c ip -g ip -m mask

-b /opt/ignite/boot/nbp.efi -o IINSTALL

(PA WINSTALL IA IINSTALL)

7-21

DVD boot

MON> vparload -p vpar2 -D 0 (0 안되면 1..2..3....)

7-24

TAPE -PA

vparboot -p vpar2 -B TAPE (예약어미리 TAPE PATH지정해야함)

7-25

TAPE -IA

vparload -p vpar2 -B tape_path

8-1

VM 219

8-4

vcpu -pcpu 를 %로 나누어 만들수있음 (최소5% 기본값10%)

8-5

lun > disk >> lv >>>>>> file

8-7

mem over head

VM host : 1.25 + 8.5 * totalmem

VM Client : OSmem + 8.3 * OSmem

전체메모리의 16%가 관리메모리로빠짐

dynamic mem : 운영중 mem 조절가능

Automatic mem : dynamic + auto

11/2

8-12

Virtual Tape

attached AVIO

8-13

Reserved Devices

-Host 만접근가능 -vg00 , /etc , /stand , localnet

9-2

pvar 제외 모든 integrity v11.31 1103 이상

mem 쓸 메모리+16%

swap host 공간만할당

/var 에 구성정보가 있음 (백업)

net online migration시 private network 추천

9-3

integrity VM

integrity Vm manager (web admin)

integrity VM online migration

9-4

/var/opt/hpvm/guests/VMNAME/vm_config.*

/opt/hpvm/bin

/var/opt/hpvm/common/*.log

/etc/rc.config.d/hpvmconf

/sbin/rc2.d/S533.hpvm

9-5

maxdsiz_64bit=34359738368

base_pagesize=4

filecache_max man =1%

hpvm swinstall 시 reboot 필요

하이퍼스레드off 권고

setboot -m off (재부팅필요)

kctune lcpu_attr=0

9-6

HPVM_ENABLE=1 (부트시vm start)

9-7

hpvmclone (속성만카피 데이터X)

(구성정보의백업이나 템플릿)

hpvmdevrtanslate (VM 구버전에서만든 legacy -> persistent 로변경)

9-8

hpvmdevinfo -vm에 할당된 storage 정보

smh - f - d 메뉴에서 확인하면 모든스토리지 쉽게확인가능

hpvmhostrdev host dev 보호

hpvmhostgdev guset dev 관리

hpvmmsg_package 서비스가드 VM

9-9

hpvmdevmgmt

-l rdev|gdev|env|server|all

reserved dev - host dev

geest dev - guest dev

host entries (server) serviceguard

environment (env) serviceguard

9-10

hpvmdevmgmt -r rdev:device_file (rdev 해제)

9-11

define disk backing stores

hpvmdevmgmt -S 20G /hpvmdisks/vmg0disk1 (파일은비추천)

기본은 1:1이나 share 설정은

hpvmdevmgmt -m gdev:/backing_store:attr:SHARE=YES

9-12

hpvmnet -c -S <name> -n <ppa num>

-c create

hpvmnet -C -S <name> -N <new_name> -n -<ppa_num>

_C clone

9-13

hpvmnet -b -S <name>

-b boot

-r restart

-h halt

-d delete

nwmgr

-p all (포트정보확인)

10-4

hpvmcreate

-K <IP> console MP ip

-L <mask> MP mask

-B manual|auto (기본값 manual 수동부팅해야됨)

-x 나머지 옵션 (주로 다이나믹관련)

10-5

scsi : Virtual IO (구형방식)

avio: Accelerated Virtual IO (신방식 2배속도)

10-6

-e min[:max] cpu 성능 min 값 % min *할당 cpu 가

총cpu 파워넘으면 다음 vm 이 스타트 안된다.

-c cpu 갯수 (리붓필요 줄엿다 원복하는건 다이나믹)

10-9

-a

network:avionan:bus,dev,MAC (guest device)

:vswitch:vswlan0 (host device)

avio_la,aviolan ( 고속) lan (구, 저속)

-m -d

bus,dev 기준

10-11

backing Stor Ttpe

attach_path (TAPE)

disk

lv

file

null (DVD , dir)

attach (구형식)

10-12

hpvmdevmgmt -S 10G /vmdisks/vm1_1 (10G프리공간필요)

hpvmmodify -P vm1 -a disk:aviostor::fie:/vmdisk/vm1_1

lvcreate -L 100 -n vm2vol /dev/vg

hpvmmodify -P vm1 -a disk:aviostor::lv:/dev/vg/rvm2vol

-a disk:aviostot::disk/dev/rdisk/disk35

-a dvd:aviostor::disk:/dev/rdisk/disk28

-a tape:aviostro::attach_path:/dev/rscsi/c0t0d0

attached dev (TAPE,DVD...)

(hpvmdevmgmt -I 명령이 attached dev file create)

10-13

hpvmstatus -d -P vm191

hpvmstatus -D (reboot 시 적용 될 옵션)

10-25

guest management soft

/opt/hpvm/guest-images

아래에 depot를 guest 에 설치

2013년 8월 29일 목요일

HP UX Crash Dump 생성 및 장애 확인

1. vi /etc/shutdownlog -> shutdown 시간 확인

21:46 Wed Sep 21, 2011. Reboot: (by etl_rep!hpadm)

15:20 Thu Jun 28, 2012. Halt: (by bk1!root)

13:42 Thu Jul 5, 2012. Reboot: (by bk1!hpadm)

11:43 Fri Jul 6, 2012. Halt: (by bk1!sysopr)

15:38 Tue Jul 31, 2012. Halt: (by bk1!sysopr)

2. vi /var/adm/syslog/OLDsyslog.log -> 장애 syslog 확인

Jul 31 15:37:35 bk1 HP-PRM: [28829]: prmconfig: configuration reset

Jul 31 15:38:09 bk1 /usr/sbin/envd[1490]: terminated by signal 15

Jul 31 15:38:09 bk1 diagmond[1486]: Exit due to user requested abort

Jul 31 15:38:10 bk1 sshd[906]: Received signal 15; terminating.

Jul 31 15:38:11 bk1 cimserver[1402]: HP-UX WBEM Services stopped.

Jul 31 15:38:14 bk1 inetd[1022]: Going down on signal 15

Jul 31 15:38:14 bk1 rpcbind: terminate: rpcbind terminating on signal. Restart with "rpcbind -w"

Jul 31 15:38:15 bk1 su: + tty?? root-sfmdb

Jul 31 15:38:19 bk1 syslogd: going down on signal 15

3. dmesg -> 부팅하면서 부터 쌓인 커널 로그확인

System Console is on the Built-In Serial Interface

iether0: INITIALIZING HP AB352-60003 PCI/PCI-X 1000Base-T Dual-port Core at hardware path 0/1/2/0

iether1: INITIALIZING HP AB352-60003 PCI/PCI-X 1000Base-T Dual-port Core at hardware path 0/1/2/1

iether2: INITIALIZING HP AD331-60001 PCI/PCI-X 1000Base-T Adapter at hardware path 0/2/1/0

Logical volume 64, 0x3 configured as ROOT

Logical volume 64, 0x2 configured as SWAP

Logical volume 64, 0x2 configured as DUMP

Swap device table: (start & size given in 512-byte blocks)

entry 0 - major is 64, minor is 0x2; start = 0, size = 33554432

Dump device table: (start & size given in 1-Kbyte blocks)

entry 0000000000000000 - major is 31, minor is 0x20000; start = 1051488, size = 16777216

Starting the STREAMS daemons-phase 1

Create STCP device files

Starting the STREAMS daemons-phase 2

$Revision: vmunix: B11.23_LR FLAVOR=perf Fri Mar 19 15:24:05 PST 2004 $

Memory Information:

physical page size = 4096 bytes, logical page size = 4096 bytes

Physical: 16775168 Kbytes, lockable: 14333252 Kbytes, available: 14657564 Kbytes

NOTICE: mod_fs_reg: Cannot retrieve configured loading phase from KRS for module: cifs. Setting to load at INIT

atdd: tuning() called

atdd: load() called

atdd: Class is tape

atdd: control init!

atdd: Load complete!

acdd: tuning() called

acdd: load() called

acdd: Class is autoch

acdd: Load complete!

0/4/2/1.8.0.255.0.2.0 atdd

0/5/1/0.8.0.255.0.3.0 atdd

0/5/1/1.8.0.255.0.4.0 atdd

4. /var/tombstones/ts99 파일내 HPMC(High Priority Machine Check) 시간 stamp 확인

ftp를 이용하여 ts99 파일을 다운후 HP 에 연락해서 분석요청.

========================================================================================================

아래는 구글 검색

[System Crash 의 종류]

1) Panic

- 하드웨어 및 소프트웨어 문제로 더 이상 시스템 운영을 진행할 수 없는 문제에 봉착 했을 때 발생

- 시스템이 적절하게 shutdown이 되지 않았을 경우 부팅하는 동안에도 발생할 수 있음.

- HPMC에 의한 패닉일 경우, 콘솔상에 HPMC tombstone 메세지가 나타남. (tombstone : 문제해결을 위한 레지스터값의 리스트 정보)

- coredump 를 dump device 에 떨어뜨리고 재기동되며, 부팅완료후 dump device 의 coredump 가 file system 으로 copy 됨.

- 대부분 reboot 후 해결되나 최악의 경우 OS 재설치 or 깨진 파일 복구 필요

2) TOC

- Application 이나 시스템의 hang으로 판단되는 경우, MC/SG에 의한 TOC

- Oracle RAC 문제시 자주 발생

3) HPMC : High priority machine check.

- fatal error로 인해 시스템이 더이상 동작할수 없는 상태이며 리부팅을 필요로 함.

- 하드웨어 문제가 대부분이고 간혹 소프트웨어적인 문제가 원인이 될수 있음

- /var/tombstomes/ts99 파일을 rc에 분석 요청 (HPMC time stamp 가 찍혀있는지 확인)

- 오류가 발생한 HW는 즉시 교체해야함.

4) LPMC : Low priority machine check

- automatically correctable error

- crash를 유발하지는 않았지만, 큰 장애로 이어질 수 있는 문제

========================================================================================================

1. 서버에 crash가 발생하면

/var/adm/crash밑에 crash.0 , crash.1....crash.n 이름으로 sub 디렉토리가

생성되며 각 디렉토리로 가면 관련 dump 파일이 있다.

2. 해당 crash 디랙토리로 이동

#cd /var/adm.crash/crash.1 (crash가 발생된 순서대로 crash.1, crash.2로 디렉토리가 생성된다.)

3. crash난 원인이 hardware인지 software인지 판단

#var/adm/crash/crash.1> q4 . 를 실행

q4 > 라는 프롬프트가 떨어짐.

q4> trace event 0 하면 다음 과 같이 2가지 형태로 나옴

stack trace for event 0

crash event was a panic

또는

q4> trace event 0

stack trace for event 0

crash event was an HPMC 또는 MCA

이때 "panic" 이면 software적인 원인에 의해 crash가 발생한것으로 이때는 dump 파일을 tar로 압축하여

HP 엔지니어에게 분석을 요청하고, "HPMC"또는 "MCA"일경우에는 hardware적인 원인에 의해 발생된것으로

/var/tombstones에 있는 mcaXXXXX화일이나 (11.23 for IA서버) ts99 (11.23 for PA 서버)가 있는지를 확인

하여 있을경우 MCA tool로 일차적으로 체크하고 필요시 역시 HP 엔지니어에게 문의를 하면 된다.

Dump 압축

1. #cd /var/adm/crash/crash.0

2. # tar cvf /tmp/hp/dump.tar . => 현재 디랙토리(var/adm/crash/crash.0)에 있는 모든것을

tmp/hp디랙토리에 dump.tar라는 파일로 묶는다.

3. #cd /tmp/hp

4. #gzip dump.tar => tar로 생성한 dump파일을 gzip로 압축한다.

HP-UX 네트워크 설정 방법

HP-UX 네트워크 설정 방법

[임시 반영 방법]

#ifconfig lan0 192.168.1.5 netmask 255.255.0.0

또는

#ifconfig lan0 192.168.1.5 netmask 255.255.0.0 up

[영구 반영 방법]

/etc/rc.config.d/netconf 파일에 환경 설정

<설정전 내용>

INTERFACE_NAME[0]=lan0

IP_ADDRESS[0]=10.130.6.11

SUBNET_MASK[0]=255.255.255.0

BROADCAST_ADDRESS[0]=""

INTERFACE_STATE[0]=""

DHCP_ENABLE[0]=0

INTERFACE_MODULES[0]=""

<설정 추가 내용> <-가상IP설정시

INTERFACE_NAME[1]=lan0:1

IP_ADDRESS[1]=10.130.6.10

SUBNET_MASK[1]=255.255.255.0

BROADCAST_ADDRESS[1]=""

INTERFACE_STATE[1]=""

DHCP_ENABLE[1]=0

[/etc/nsswitch.conf 부분 수정]

다음 부분에 다음과 같이 추가/수정하면 된다.

hosts: dns [NOTFOUND=return] nis [NOTFOUND=return] files

/etc/nsswitch.conf 파일이 없다면 /etc/nsswitch.hp_defaults파일을 복사하여 사용

#cp /etc/nsswitch.hp_defaults /etc/nsswitch.conf

******* TIP *****

hosts : files [NOTFOUND=continue] dns

위 내용은 hosts 파일(/etc/hosts)에 ip와 address가 매핑되어 있지 않다면 (NOTFOUND) dns로 읽으라(continue)는 뜻.

[Name server 등록-DNS주소 설정]

/etc/resolv.conf 파일을 추가/수정 한다.

# vi /etc/resolv.conf

##하기 내용을 추가

nameserver 168.126.63.1

## 네임서버가 여러개 일 경우 다수 등록 가능

[host명 변경]

/etc/hosts 부분 추가/수정

# vi /etc/hotst

127.0.0.1 localhost loopback

192.168.1.61 skttb1

ip 입력 사용할 호스트명 입력

[재시작 방법]

/sbin/init.d/net stop

/sbin/init.d/net start

- 네트워크 인터페이스 검색 : #lanscan

- 네트워크 설정명령(diag) : #lanadmin

- 네트워크 인터페이스 지원 속도 확인 : #lanadmin -s 900

※ 여기서 900은 PPA number

- APA 구성 카드 목록 확인 : #lanscan -q

※ HP APA 구성 시 config 설정 주의 : stanby=on 확인

- 네트워크 인터페이스 현재 동작 속도 확인 : #lanadmin -x 1

※ 여기서 1은 PPA number

- 네트워크 인터페이스 autonegotiation 모드 설정 : #lanadmin -X auto_on 1

ifconfig 인터페이스명

ioscan -knfC lan

==========================================================================

[ IP 설정 ]

/etc/rc.config.d/netconf파일 수정

INTERFACE_NAME[1]="lan1“

IP_ADDRESS[1]="192.168.1.30“

SUBNET_MASK[1]="255.255.255.0“

BROADCAST_ADDRESS[1]="“

INTERFACE_STATE[1]="“

DHCP_ENABLE[1]=0

INTERFACE_MODULES[1]=""

DEFAULT_INTERFACE_MODULES="“

ROUTE_DESTINATION[0]="default“

ROUTE_GATEWAY[0]=192.168.1.1

ROUTE_COUNT[0]=1

ROUTE_MASK[0]= ROUTE_ARGS[0]=

[ NIC 속도 및 mode 설정 ]

/etc/rc.config.d/hpbtlanconf 파일 수정

##################################################################### # @(#)B.11.31_LR hpbtlanconf $Revision: i80/32002/09/1010:05:45

# hpbase100conf: contains configuration values for HP PCI/HSC 100BASE-T

# interfaces

#

# HP_BTLAN_INTERFACE_NAMEName of interface (lan0, lan1...)

# HP_BTLAN_STATION_ADDRESSStation address of interface

# HP_BTLAN_SPEEDSpeed and duplex mode

# Can be one of : 10HD, 10FD, 100HD, 100FD and

# AUTO_ON.

# HP_BTLAN_MTU Maximum Transmission Unit (MTU)

# Integer value between 257 and 1500, inclusive.

#

# The interface name, major number, card instance and ppa may be # obtained from the lanscan(1m) command. # # The station address and duplex are set through the lanadmin(1m) command.

# #####################################################################

HP_BTLAN_INTERFACE_NAME[0]=

HP_BTLAN_STATION_ADDRESS[0]=

HP_BTLAN_SPEED[0]= HP_BTLAN_MTU[0]=

###########################################################################

#The HP_BTLAN_INIT_ARGS are reserved by HP.They are NOT user changeable.

###########################################################################

HP_BTLAN_INIT_ARGS=“

HP_BTLAN_STATION_ADDRESS

HP_BTLAN_SPEED HP_BTLAN_MTU"

# End of hpbtlanconf configuration file

[ NameServer 설정 ]

cat /etc/resolv.conf domain test.com

nameserver192.168.1.2 # primary dns

[ Net Service 구동/재시작 ]

# /sbin/init.d/net stop

# /sbin/init.d/net start

[ IP 설정 ]

ifconfig lan6192.168.0.100 netmask 255.255.255.0 up

route add net192.168.0.0 netmask 255.255.255.0 192.168.0.1 1

[ 네트웍 카드별 아이피 확인 ]

# netstat ?in

Name Mtu Network Address Ipkts Ierrs Opkts Oerrs Coll

lan1 1500 192.168.1.0 192.168.1.111 57846873 0 173730152 0 0

lo0 32808 127.0.0.0 127.0.0.1 41611065 0 41611062 0 0

lan900 1500 xxx.xxx.xxx.0 xxx.xxx.xxx.xxx 3053587325 0 2956102205 0 0

--> lan0, lan1, lan2 등은 물리적 NIC이고,lan900 부터는 APA로 구성된 논리적 NIC이다.

[ 시스템에 인식된 물리적 NIC 확인 ]

# ioscan -fnk ?C lan

ClassIH/W PathDriver S/W StateH/W TypeDescription

케이블 port 와 연결 확인

연결 안되었을 경우

skttbsvr:[/]lanadmin -x 7

The link is down. The speed and other link state information

are undefined. The configuration specified for this card is:

Speed = 100 Full-Duplex.

Autonegotiation = Off.

연결 되었을 경우

skttbsvr:[/]lanadmin -x 0

Speed = 1000 Full-Duplex.

Autonegotiation = On.

=================================================================== lan20/3/1/0ietherCLAIMEDINTERFACEHP A7012-60001 PCI/PCI-X 1000Base-T Dual-port Adapter

lan30/3/1/1ietherCLAIMEDINTERFACEHP A7012-60001 PCI/PCI-X 1000Base-T Dual-port Adapter

lan00/4/2/0ietherCLAIMEDINTERFACEHP AB352-60003 PCI/PCI-X 1000Base-T Dual-port Core

lan10/4/2/1ietherCLAIMEDINTERFACEHP AB352-60003 PCI/PCI-X 1000Base-T Dual-port Core

--> Core 는 보드에 내장된 NIC.Adapter는 추가로 장착된 NIC

[ NIC별 Link 상태 ]

# lanscan

Message catalog can't be opened/accessed for language ko_KR.eucKR.

Language C will used.

Hardware StationCrd HdwNet-InterfaceNMMACHP-DLPI DLPI

Path Address In# State NamePPA ID Type Support Mjr#

0/3/1/0 0x00306E5DFA7C 2 UP lan2 snap2 2 ETHER Yes 119

0/4/2/1 0x001A4B08963D 1 UP lan1 snap1 4 ETHER Yes 119

LinkAgg0 0x001A4B08963C 900 UP lan900 snap900 6 ETHER Yes 119

LinkAgg1 0x000000000000 901 DOWN lan901 snap901 7 ETHER Yes 119

LinkAgg2 0x000000000000 902 DOWN lan902 snap902 8 ETHER Yes 119

LinkAgg3 0x000000000000 903 DOWN lan903 snap903 9 ETHER Yes 119

LinkAgg4 0x000000000000 904 DOWN lan904 snap904 10 ETHER Yes 119

[ NIC 속도/모드확인 ]

속도확인

# lanadmin -s 900 Speed= 1000000000

-s 옵션 뒤에 PPA Number(lanscan -p 로 확인가능)를 적어준다.

속도 및 모드 확인

# lanscan -x 1

전체 설정 및 통계 확인

# lanscan -g 900

[ APA 구성된 물리적 NIC 확인하기 ]

# lanscan ?q

2

1

9000

3

901

902

903

904

논리적 NIC 900 에 할당된 물리적 NIC이lan0와 lan3으로 묶였다는 걸 알 수 있다.

========================================================================

routing

route add default 211.115.7.254 1

lanadmin -X auto_off 3

lanadmin -X 100fd 3

[임시 반영 방법]

#ifconfig lan0 192.168.1.5 netmask 255.255.0.0

또는

#ifconfig lan0 192.168.1.5 netmask 255.255.0.0 up

[영구 반영 방법]

/etc/rc.config.d/netconf 파일에 환경 설정

<설정전 내용>

INTERFACE_NAME[0]=lan0

IP_ADDRESS[0]=10.130.6.11

SUBNET_MASK[0]=255.255.255.0

BROADCAST_ADDRESS[0]=""

INTERFACE_STATE[0]=""

DHCP_ENABLE[0]=0

INTERFACE_MODULES[0]=""

<설정 추가 내용> <-가상IP설정시

INTERFACE_NAME[1]=lan0:1

IP_ADDRESS[1]=10.130.6.10

SUBNET_MASK[1]=255.255.255.0

BROADCAST_ADDRESS[1]=""

INTERFACE_STATE[1]=""

DHCP_ENABLE[1]=0

[/etc/nsswitch.conf 부분 수정]

다음 부분에 다음과 같이 추가/수정하면 된다.

hosts: dns [NOTFOUND=return] nis [NOTFOUND=return] files

/etc/nsswitch.conf 파일이 없다면 /etc/nsswitch.hp_defaults파일을 복사하여 사용

#cp /etc/nsswitch.hp_defaults /etc/nsswitch.conf

******* TIP *****

hosts : files [NOTFOUND=continue] dns

위 내용은 hosts 파일(/etc/hosts)에 ip와 address가 매핑되어 있지 않다면 (NOTFOUND) dns로 읽으라(continue)는 뜻.

[Name server 등록-DNS주소 설정]

/etc/resolv.conf 파일을 추가/수정 한다.

# vi /etc/resolv.conf

##하기 내용을 추가

nameserver 168.126.63.1

## 네임서버가 여러개 일 경우 다수 등록 가능

[host명 변경]

/etc/hosts 부분 추가/수정

# vi /etc/hotst

127.0.0.1 localhost loopback

192.168.1.61 skttb1

ip 입력 사용할 호스트명 입력

[재시작 방법]

/sbin/init.d/net stop

/sbin/init.d/net start

- 네트워크 인터페이스 검색 : #lanscan

- 네트워크 설정명령(diag) : #lanadmin

- 네트워크 인터페이스 지원 속도 확인 : #lanadmin -s 900

※ 여기서 900은 PPA number

- APA 구성 카드 목록 확인 : #lanscan -q

※ HP APA 구성 시 config 설정 주의 : stanby=on 확인

- 네트워크 인터페이스 현재 동작 속도 확인 : #lanadmin -x 1

※ 여기서 1은 PPA number

- 네트워크 인터페이스 autonegotiation 모드 설정 : #lanadmin -X auto_on 1

ifconfig 인터페이스명

ioscan -knfC lan

==========================================================================

[ IP 설정 ]

/etc/rc.config.d/netconf파일 수정

INTERFACE_NAME[1]="lan1“

IP_ADDRESS[1]="192.168.1.30“

SUBNET_MASK[1]="255.255.255.0“

BROADCAST_ADDRESS[1]="“

INTERFACE_STATE[1]="“

DHCP_ENABLE[1]=0

INTERFACE_MODULES[1]=""

DEFAULT_INTERFACE_MODULES="“

ROUTE_DESTINATION[0]="default“

ROUTE_GATEWAY[0]=192.168.1.1

ROUTE_COUNT[0]=1

ROUTE_MASK[0]= ROUTE_ARGS[0]=

[ NIC 속도 및 mode 설정 ]

/etc/rc.config.d/hpbtlanconf 파일 수정

##################################################################### # @(#)B.11.31_LR hpbtlanconf $Revision: i80/32002/09/1010:05:45

# hpbase100conf: contains configuration values for HP PCI/HSC 100BASE-T

# interfaces

#

# HP_BTLAN_INTERFACE_NAMEName of interface (lan0, lan1...)

# HP_BTLAN_STATION_ADDRESSStation address of interface

# HP_BTLAN_SPEEDSpeed and duplex mode

# Can be one of : 10HD, 10FD, 100HD, 100FD and

# AUTO_ON.

# HP_BTLAN_MTU Maximum Transmission Unit (MTU)

# Integer value between 257 and 1500, inclusive.

#

# The interface name, major number, card instance and ppa may be # obtained from the lanscan(1m) command. # # The station address and duplex are set through the lanadmin(1m) command.

# #####################################################################

HP_BTLAN_INTERFACE_NAME[0]=

HP_BTLAN_STATION_ADDRESS[0]=

HP_BTLAN_SPEED[0]= HP_BTLAN_MTU[0]=

###########################################################################

#The HP_BTLAN_INIT_ARGS are reserved by HP.They are NOT user changeable.

###########################################################################

HP_BTLAN_INIT_ARGS=“

HP_BTLAN_STATION_ADDRESS

HP_BTLAN_SPEED HP_BTLAN_MTU"

# End of hpbtlanconf configuration file

[ NameServer 설정 ]

cat /etc/resolv.conf domain test.com

nameserver192.168.1.2 # primary dns

[ Net Service 구동/재시작 ]

# /sbin/init.d/net stop

# /sbin/init.d/net start

[ IP 설정 ]

ifconfig lan6192.168.0.100 netmask 255.255.255.0 up

route add net192.168.0.0 netmask 255.255.255.0 192.168.0.1 1

[ 네트웍 카드별 아이피 확인 ]

# netstat ?in

Name Mtu Network Address Ipkts Ierrs Opkts Oerrs Coll

lan1 1500 192.168.1.0 192.168.1.111 57846873 0 173730152 0 0

lo0 32808 127.0.0.0 127.0.0.1 41611065 0 41611062 0 0

lan900 1500 xxx.xxx.xxx.0 xxx.xxx.xxx.xxx 3053587325 0 2956102205 0 0

--> lan0, lan1, lan2 등은 물리적 NIC이고,lan900 부터는 APA로 구성된 논리적 NIC이다.

[ 시스템에 인식된 물리적 NIC 확인 ]

# ioscan -fnk ?C lan

ClassIH/W PathDriver S/W StateH/W TypeDescription

케이블 port 와 연결 확인

연결 안되었을 경우

skttbsvr:[/]lanadmin -x 7

The link is down. The speed and other link state information

are undefined. The configuration specified for this card is:

Speed = 100 Full-Duplex.

Autonegotiation = Off.

연결 되었을 경우

skttbsvr:[/]lanadmin -x 0

Speed = 1000 Full-Duplex.

Autonegotiation = On.

=================================================================== lan20/3/1/0ietherCLAIMEDINTERFACEHP A7012-60001 PCI/PCI-X 1000Base-T Dual-port Adapter

lan30/3/1/1ietherCLAIMEDINTERFACEHP A7012-60001 PCI/PCI-X 1000Base-T Dual-port Adapter

lan00/4/2/0ietherCLAIMEDINTERFACEHP AB352-60003 PCI/PCI-X 1000Base-T Dual-port Core

lan10/4/2/1ietherCLAIMEDINTERFACEHP AB352-60003 PCI/PCI-X 1000Base-T Dual-port Core

--> Core 는 보드에 내장된 NIC.Adapter는 추가로 장착된 NIC

[ NIC별 Link 상태 ]

# lanscan

Message catalog can't be opened/accessed for language ko_KR.eucKR.

Language C will used.

Hardware StationCrd HdwNet-InterfaceNMMACHP-DLPI DLPI

Path Address In# State NamePPA ID Type Support Mjr#

0/3/1/0 0x00306E5DFA7C 2 UP lan2 snap2 2 ETHER Yes 119

0/4/2/1 0x001A4B08963D 1 UP lan1 snap1 4 ETHER Yes 119

LinkAgg0 0x001A4B08963C 900 UP lan900 snap900 6 ETHER Yes 119

LinkAgg1 0x000000000000 901 DOWN lan901 snap901 7 ETHER Yes 119

LinkAgg2 0x000000000000 902 DOWN lan902 snap902 8 ETHER Yes 119

LinkAgg3 0x000000000000 903 DOWN lan903 snap903 9 ETHER Yes 119

LinkAgg4 0x000000000000 904 DOWN lan904 snap904 10 ETHER Yes 119

[ NIC 속도/모드확인 ]

속도확인

# lanadmin -s 900 Speed= 1000000000

-s 옵션 뒤에 PPA Number(lanscan -p 로 확인가능)를 적어준다.

속도 및 모드 확인

# lanscan -x 1

전체 설정 및 통계 확인

# lanscan -g 900

[ APA 구성된 물리적 NIC 확인하기 ]

# lanscan ?q

2

1

9000

3

901

902

903

904

논리적 NIC 900 에 할당된 물리적 NIC이lan0와 lan3으로 묶였다는 걸 알 수 있다.

========================================================================

routing

route add default 211.115.7.254 1

lanadmin -X auto_off 3

lanadmin -X 100fd 3

RAID 레벨

레이드(RAID) 라고

누구나 한번쯤은 들어 봤을 듯합니다.

PC를 많이 접하지 않는 분이시라면 바퀴잡는 레이드가 떠오르실 것이고, 게임을 많이 하시는 분이라면 온라인 게임에서의 보스급 몬스터 사냥 레이드~!!

그러나 제가 약간 언급할것은

HDD 구성의 Riad입니다 .^^

PC 부품중에서 ODD (CD/DVD/Multi)를 제외하고 유일하게 아날로그적인 요소가 들어간게 HDD 이고기계적인 동작 구조로 인해 급격한 성능 향상이 쉽지 않기 때문에 PC 부품중에서 가장 느린 부분으로 인식 되어 온 것도 어느정도 사실입니다.

레이드는 이런 HDD의 성능을 유일하게 향상 시킬수 있는 방법이었으나 추가 적인 비용이 많이 들어서 일부 하이엔드 유저나 보다 빠른 게임을위한 몇몇 유저들만이 사용하는 시스템구성이었습니다.

그러던것이 하드용량의 증가와 함께 HDD의 가격이 하락되는 시점에서 알려질듯 하다가... SSD의 출현이 그 앞을 가로 막고 있지 않나 합니다.

SSD의 레이드 구성~!!!

HDD로 도미노 게임 해보는것 다음으로 꼭 구성해보고 보고 싶은 희망이 있지만... 주머니 사정상 내년을 기약해야 될듯 합니다. 일단 단일 SSD의 성능 만으로도 충분히 만족하니까요 ^^ (일단 케이스가 먼저~ ^^) RAID ( Redundant Array of Inexpensive Disks 또는 Redundant Array of Independent Disks )

RAID ( Redundant Array of Inexpensive Disks 또는 Redundant Array of Independent Disks )

1988년 버클리 대학의 3명의 과학자가 제안한 이론으로 그 당시에는 하드디스크의 용량이 제한적이었고, 함부로 사용하는 이도 드물 정도로 값도 비쌌기 때문에 보다 저렴하며 용량이 적고, 성능이 낮은 하드디스크를 묶어 중복 구성함으로써, 성능이 좋은 고가의 대용량 하드디스크 장비와 겨뤄 손색이 없도록 하는 것이 주목적이었습니다.

그러나 그들이 열심히 RAID를 연구하는 동안 Storage 기술의 발전으로 용량대비 가격이 지속적으로 하락하였으므로 애초 주목적이었던 가격적인 면보다는 데이터의 안정성과 에러 보정, 그리고 하드디스크의 장애에 의한 데이터의 손실을 막기 위한 측면이 강조되었고, RAID의 의미는'Inexpensive'에서 'Independent'로 의미가 바뀌게 되었습니다.

단순히 구성으로만 보자면 지금 많이들 사용하는partition의 반대 비슷한 개념정도 됩니다.

파티션이 하나의 물리적인 드라이브를 여러개의 논리적 드라이브로 분할한것 이라면.. 레이드는 여러개의 물리적 드라이브를 하나의 논리적 드라이브로 묶는 방식 입니다.

보다 정확한 파티션의 반대 개념은 단순히 구성을 묶기만 하는 JBOD (Just a Bunch Of Disks 또는Just a Bunch Of Drives) 가 더 가까울듯 합니다. 이것은 여러 개의 물리 드라이브를 논리적인 하나의 커다란 드라이브로 결합해주는 것일 뿐, 각각의 드라이브를 독립적으로 사용하는 것에 비해 어떠한 장점도 없으니까요.

RAID 시스템은 동일한 데이터를 여러 개의 디스크에 중복 저장하면서도, 운영체계에는 하나의 단일 디스크로 인식시킴으로써, 내고장성의 증가와 데이터 접근 효율성을 높여주는 장점이 있습니다.레이드는 하드디스크가 묶이는 방식에 따라 레벨로 나뉘어지며 효율성과 안정성을 고려하여

레벨을 결정하게 됩니다.

초기 RAID는 6단계의 레벨로 나뉘어졌으나,

현재에는 보다 많은 RAID 레벨이 존재하고 있습니다. 레벨은 성능순이나 중요도순으로 숫자가 정해진 것은 아니므로, RAID 레벨 1이 RAID 레벨 0보다 우수하다거나 하는 등으로 단정지어서는 안됩니다.

RAID Level 0 ( 레이드 0 ) : 필요 드라이브 최소 2개이상

스트리핑 구성시 충족요건은..같은 모델의 하드디스크와 같은 용량이어야 한다는 전제 조건이 있습니다.

레이드 0 구성시 중요데이터는 반드시 Back-up 하셔야 합니다.

레벨 0은 RAID의 가장 기본적인 구현방식으로 Striping(스트라이핑)이라고 합니다.

이것은 하나의 데이터를 여러 드라이브에 분산 저장을 함으로써 빠른 입출력을 가능하게 합니다.

1부터 100까지의 숫자로 이루어진 데이터가 있다면

이것을 1부터 100까지 순서대로 읽게 되는 상황이 일반적인 하드디스크의 구성이고

2개의 하드 디스크로 레벨0 을 구성하면 하나는 1~50 까지만 읽고

다른 하나는 51부터 100까지만 읽고 저장하기 때문에 그 속도는 2배가 됩니다.

즉 3개로 구성되면 속도는 3배가 되고 10개로 구성되면 그 속도는 1/10 로 줄어 들게 됩니다.

제글의 부족한 부분을 댓글로 채워주신 분의 의견이라 첨부합니다.

위에서 설명하셨듯이 하나의 데이터는 Stripe(스트라이프) 기술을 이용해서

여러개의 같은, 일정한 크기로 쪼개집니다. 그리고 이 쪼개진 하나하나의 조각을

Stripe Unit(스트라이프 유닛)이라고 합니다.

다시한번 말하자면, 1에서부터 100까지의 숫자로 이루어진 데이터가 있습니다.

이 데이터는 스트라이핑에 따라 두 개의 스트라이프 유닛으로 나뉘는데

1에서부터 50까지, 51부터 100까지 각각 두개의 스트라이프 유닛에 나뉘어 들어갑니다.

여기까지 이해하셨으면 그 다음부터는 Rapter님의 설명을 그대로 따라가셔도 좋습니다. 나뉜 두개의 스트라이프는 두개의 디스크에 차례로 들어가는 거죠.

레벨 0은 분산 저장에만 초점이 맞춰져 있어 하드디스크의 속도 향상에는 무척 도움이 되지만,

Striping(스트라이핑) 되어 있는 하드디스크 중 1개만 장애를 일으키더라도 데이터를 모두 유실할

위험성이 있습니다.

예 ) "어린이" 라는 단어를 2개의 드라이브(하드 디스크)로 구성된 Raid 0 에 저장한다면

한개의 드라이브는 "ㅇ , ㄹ, ㄴ, ㅇ" 라는 자음만 저장하고

다른 하나는 " ㅓ, ㅣ, ㅣ " 이런 모음만 저장합니다.

따라서 저장하거나 불러오는 속도는 빠르지만 하나의 디스크에서 에러가 발생하면...

완전한 데이터를 불러오지 못하게 되는 것입니다.

300GB 두개로 레이드0 을 구성하면 600GB의 단일 드라이브로 나타나고 성능 또한 2배이지만

하나의 디스크에서 손실이 발생하면 둘다 사용하지 못하게 됩니다. 안전성이 낮은 구성입니다.

RAID Level 1 ( 레이드 1 ) : 필요 드라이브 최소 2개이상

레벨 1은 2개의 하드디스크가 사용되며, 하나의 하드디스크에 기록되는 모든 데이터가 나머지 하나의 하드디스크에 고스란히 복사되는 방법으로 저장하게 됩니다. 두 개의 하드디스크에는 한치의 오차도 없이 똑같은 데이터가 저장이 되기 때문에 Mirroring(미러링)이라고 합니다. 이 경우 2개의 하드디스크 중 1개가 장애를 일으키더라도 남은 1개의 데이터는 장애를 일으킨 하드디스크의 데이터와 똑같기 때문에 안정성 측면에서 상당히 우수한 구성입니다.

읽기에서는 성능의 향상이 있으나, 쓰기에서의 속도 향상은 별반 차이가 없고, 전체 공간의 50%만 이용할 수 있다는 문제점이 있습니다. 때문에 매우 중요한 파일을 백업 받을 일이 없는 개인 사용자의 경우 하드디스크 두 개로 한 개 용량만 사용해야 한다는 단점이 있습니다.

두 레벨의 용량의 효율성을 비교하면...

레벨0은 속도와 용량의 효율성은 높으나 안정성이 떨어지고...

레벨1은 안전성은 뛰어나나 속도와 효율성이 떨어집니다.

그래서 나온것이 Raid 3과 4 인데...

RAID Level 2 는 기록용 드라이브와 테이터 복구용 드라이브를 별도로 두는데..

4개 하드 디스크에 기록하기 위해서는 3개의 부가 데이터를 기록해야 되기 때문에 효율성 측면에서

거의 사용하지는 않습니다. RAID 2는 RAID 0처럼 스트라이핑 방식이지만 에러 체크와 수정을 할 수 있도록 Hamming Code를 사용하고 있는 것이 특징입니다. 레벨 4가 나오면거 거의 사용하지 않는 기술입니다. 레벨2의 설명은 요정도 패스 ^^

RAID Level 3, 4 ( 레이드 3, 4 ) : 필요 드라이브 최소 3개이상

RAID 3, RAID 4는 RAID 0, 1의 문제점을 보완하기 위한 방식으로 3, 4로 나뉘긴 하지만 RAID 구성 방식은 거의 같습니다. RAID 3,4는 기본적으로 RAID 0과 같은 스트라이핑(Striping) 구성을 하고 있어 성능을 보완하고 디스크 용량을 온전히 사용할 수 있게 해주는데, 여기에 추가로에러 체크 및 수정을 위해서 패리티(Parity) 정보를 별도의 디스크에 따로 저장하게 합니다.

Raid 3 과 Raid 4의 차이점은

Raid 3은 Byte단위로 데이터를 저장하는 반면 Raid 4는 Block단위로 저장합니다.

Block단위로 저장을 할 경우 작은 파일의 경우는 한번의 작업으로 데이터를 읽을 수 있기 때문에 성능상의 장점이 있습니다. 레벨 3은 동기화를 거처야 하기 때문에 3보다는 레벨 4를 많이 사용합니다.

데이터가 저장되어 있는 드라이브에 장애가 발생되었을 경우에는 패리티 정보를 이용하여 복구할 수 있으나, 정작 패리티 정보가 저장되어 있는 하드디스크에 장애가 발생하면 복구가 불가능하다는 단점이 있습니다. 또한 패리티 하드디스크에 병목현상이 생겨 속도가 저하될 수 도 있습니다.

레이드 0의 구성에 백업용 드라이브 하나 더 달아서 안정성을 확보한 구성입니다.

그러나 레벨 3과 레벨 4의 단점을 보완한 레벨 5의 등장으로 저 역시 한번도 구성 해본적은 없습니다.

이쯤 보시면 이제 Raid에 대해서 대충 감이 오시죠?

Raid Level 0 의 Striping(스트라이핑) : 데이터를 쪼개서 분산 저장 해서 속도향상

Raid Level 1 의 Mirroring ( 미러링 ) : 안전성을 중요시 하지만 드라이브 용량 이용의 비효율성

Raid Level 3 의 Parity ( 패리티 ) : 데이터 오류 체크 기술로 레벨0읠 불안전성을 보완

이 3가지를 어떻게 구성하는냐에 따라서 Raid의 레벨이 결정됩니다.

이제 Raid 5 와 Raid 6 그리고 이들의 복합 구성인

Raid 0 +1 또는 1+0 , Raid 5 + 0, Raid 5 + 1 에 관해서는 다음편에... ^^

Raid 레벨 0~4까지 다루었습니다.

해당내용은 아래의 링크를 아래 참고 하세요.

레이드 ( RAID ) 의 레벨과 구성 ( 1부 : Raid Level 0,1,2,3,4 )

간단하게 정리하자면

Raid Level 0 인 Striping(스트라이핑)은

데이터를 쪼개서 저장하는

즉, 분산 저장 해서 속도향상을 위한 레벨이고

Raid Level 1 의 Mirroring ( 미러링 )은

안전성을 좋지만 드라이브 용량 이용의 비효율성이 있습니다

Raid Level 3,4 는 Parity ( 패리티 : 데이터 오류 체크 기술)로 레벨0의 불안전성을 보완한것입니다.

이제 가장 많이 사용하는

Raid Level 5 와 Level 6 복합구성인 01, 50, 60 등에 관해서 말하겠습니다.

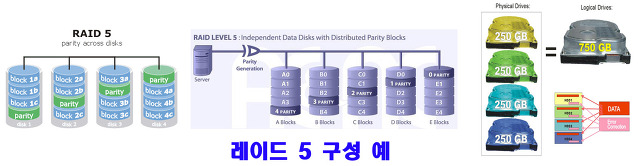

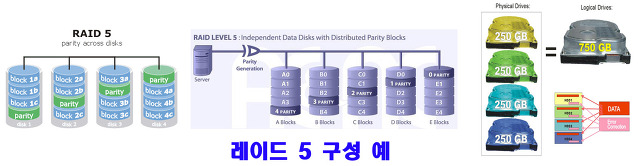

RAID Level 5 ( 레이드 5 ) : 필요 드라이브 최소 3개이상

레벨 5는 레벨 3과 레벨 4의 단점을 보완한 방식으로, 패리티 정보의 저장을 전담하는 하드디스크 대신 모든 하드디스크에 패리티 정보를 분산 저장합니다. 이 방식은 쓰기(Write)에는 패리티 정보가 분산되어

저장되기 때문에 Level 3, 4의 단점이었던 병목을 줄여주지만, 읽기(Read)에서는 사방에 흩어져 있는

패리티 정보를 갱신하며 읽게 되기 때문에 성능 저하가 생길 수밖에 없습니다.

이러한 단점 역시 컨트롤러에 지능형 캐쉬를 내장하여 속도저하를 최소화시키는 역할을 하고 있습니다.

성능면에서 Raid 0 보다 떨어지지만 성능, 안정성, 용량 3 부분을 고려한 형태입니다.

하나의 드라이브가 고장날 경우 다른 드라이브에 별도로 저장된 패리티( Parity ) 정보를 정보를 통해서

복구하고 손상된 드라이브의 패리티 ( Parity ) 정보는 나머지 하드에 있는덷 테이터를 토대로 다시 작성할 수 있습니다. 그러나 별도의 패리티 정보를 저장하는 작업을 해야 하기 때문에 RAID Level 1 보다는

쓰기 성능이 떨어집니다.

가끔 전화와서

" 고객님~!" " 계란을 한바구니에 담지마라~!! 그러면서~ 좋은 상품이 있어서~~."

요러 면서 광고 시작하죠?

이 멘트가 적용된 레이드 구성입니다. 각각의 하드에 패리티 정보를 분산 시킨거죠 ^^

RAID 3, 4와 달리 패리티 정보가 저장된 디스크가 따로 없어 패리티 디스크 고장과 같은 문제에서

자유롭고 실제 서버/워크스테이션에서 가장 많이 사용되는 방식입니다.

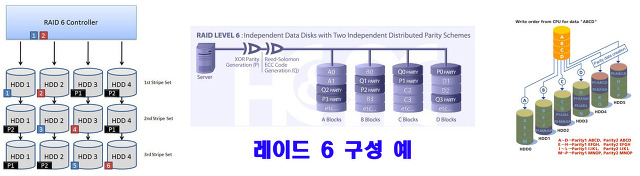

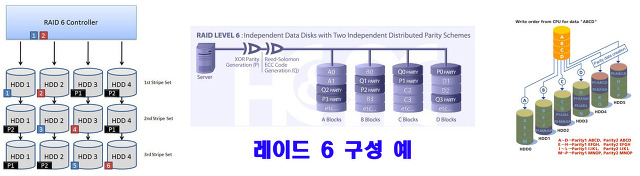

RAID Level 6 ( 레이드 6 ) : 필요 드라이브 최소 4개이상

레벨 6은 RAID 5와 같은 개념이지만 다른 드라이브들 간에 분포되어 있는 2차 패리티 정보를 넣어 2개의 하드에 문제가 생겨도 데이터를 복구할 수 있습니다. RAID 5보다 더욱 데이터 안정성을 고려하는 시스템에서 사용합니다.

하드를 스트라이핑으로 묶었기 때문에 RAID 0+1이나 RAID 10(1+0)보다 성능은 더 높고 신뢰성도 우수 하지만 패리티 정보를 2중으로 저장하면서 읽기 성능은 RAID 5와 비슷하지만 쓰기 작업 구현이 아주 복잡해서 일반적으로 잘 사용하지 않습니다.

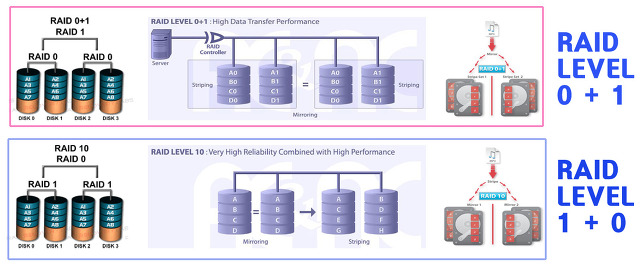

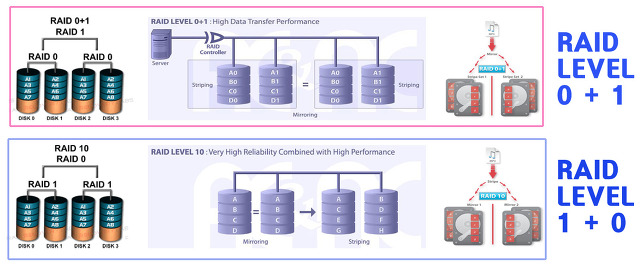

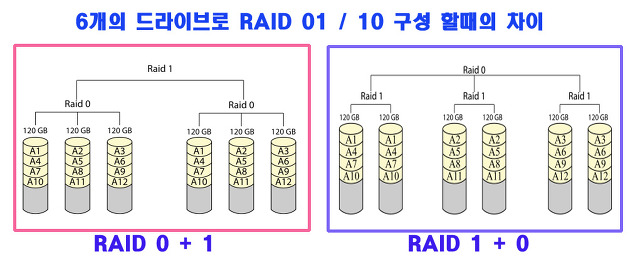

RAID Level 0+1 / 1+0 (레이드 01 / 10 ) : 필요 드라이브 최소 4개

간단히 말하자면 레이드 레벨 0과 레벨 1의 복합 구성입니다.

레벨 0의 Striping과 레벨 1의 Mirroring의 기능이 합쳐진 것으로, 분산 저장을 통한 성능 향상을 꾀할 수 있으면서 데이터의 안정성 또한 보장받을 수 있습니다. 때문에 속도 및 안정성 두 마리의 토끼를 다 잡은 듯 보이지만, 여전히 전체 용량의 50%만 사용할 수 있는 것은 변함이 없으며, 비용이 많이 든다는 문제점이 있습니다.

01과 10의 차이는 어느 쪽을 먼저 구성하느냐의 차이입니다.

4개의 드라이브로 구성한다면 위의 이미지 처럼 그 차이는 없습니다.

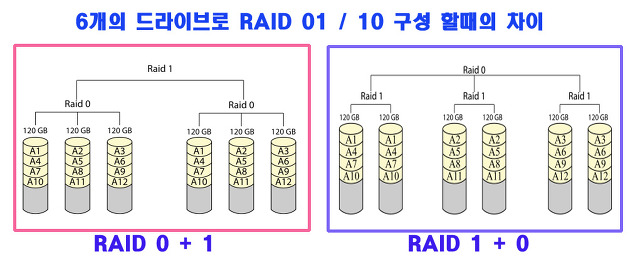

그러나 6개의 드라이브로 구성한다면 달라지게 됩니다.(아래 이미지 참고)

드라이브가 6개일때 01의 구성은 3:3 으로 구성되지만

10의 구성은 2:2:2 로 구성되게 됩니다.

드라이브가 6개일때...

RAID 0+1은 RAID 0으로 구성된 드라이브들을

최종적으로 RAID 1로 묶는 것이라 각각 3개씩 하드 가 나눠지며,

RAID 1+0은 2개씩 RAID 1으로 묶여있는 하드들이 RAID 0으로 구성됩니다.

RAID 0+1의 경우 1개의 하드만 고장나서

복구해도 다른 RAID 0 구성에서 나머지 하드까지 데이터 전체를 복구해야 하지만,

RAID 1+0으로 만든 시스템은

고장난 하드가 하드 1개라고 하면 미러링으로 묶인 하드를 통해 데이터만 복구하면 되므로

실제로 운용하는데는 RAID 1+0 이 훨씬 유리합니다.

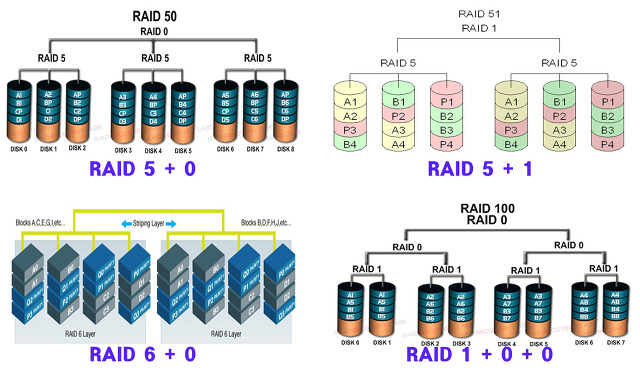

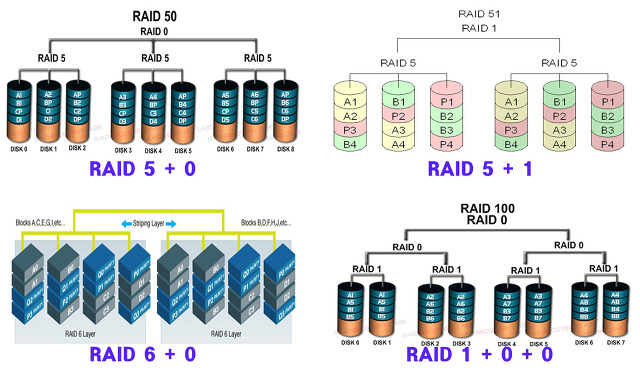

이외에 Raid 51 / 15 , Raid 05 / 50 , Raid 60 이나 Raid100 등 역시 기존의 레벨의 복합적 구성입니다.

레벨 0 이 들어가면 성능의 향상을 기대할수 있으나 안정성은 불안하게 됩니다.

레벨 1 이 들어 가면 안전성을 확복할수 있으나 용량의 감소 또한 감수 해야 됩니다.

레벨 5나 6의 구성에 최소 3~4개의 드라이이브가 소모되기 때문에

이들의 복합적인 구성은 최소 6개 이상의 드라이가 있어야 가능한 구성입니다.

한마디로 돈 많이 들어간다는 거죠. ^^

마지막으로 나름대로 정리해본 레이드 레벨(RAID Level)에 따른 정리 표 입니다.

< 이미지를 클릭하시면 크게 보실수 있습니다. Image Click~!! >

랜덤 읽기/ 쓰기의 성능의 향상은 체감속도의 향상과 같습니다. 프로그램을 런칭하는 속도가 랜덤 엑세스의 성능과 비례한다고 보시면 됩니다. 그리고 순차 읽기 / 쓰기는 영화파일과 같은 대용량의 파일을 이동할때의 성능 이라고 생각하시면 됩니다. ~ ^^

레벨 5 이상의 복합 구성은(50, 60) 거의 서버용이기 때문에 비용문제와 함께 거의 사용하지 않습니다.

메인보드에서 레이드 5레벨을 지원한다면 5를 추천하지만 일반적으로 많이 사용하는 것이 레이드 레벨 0 과 1의 복합 구성이 01 또는 10 입니다. 인텔의 H57칩셋 또는 P55 칩셋을 탑제한 메인보드는 레이드 5레벨까지 구성을 지원합니다. ~ ^^ 구입하실때 참고하세요.

출처 http://smsinfo.tistory.com/176

누구나 한번쯤은 들어 봤을 듯합니다.

PC를 많이 접하지 않는 분이시라면 바퀴잡는 레이드가 떠오르실 것이고, 게임을 많이 하시는 분이라면 온라인 게임에서의 보스급 몬스터 사냥 레이드~!!

그러나 제가 약간 언급할것은

HDD 구성의 Riad입니다 .^^

PC 부품중에서 ODD (CD/DVD/Multi)를 제외하고 유일하게 아날로그적인 요소가 들어간게 HDD 이고기계적인 동작 구조로 인해 급격한 성능 향상이 쉽지 않기 때문에 PC 부품중에서 가장 느린 부분으로 인식 되어 온 것도 어느정도 사실입니다.

레이드는 이런 HDD의 성능을 유일하게 향상 시킬수 있는 방법이었으나 추가 적인 비용이 많이 들어서 일부 하이엔드 유저나 보다 빠른 게임을위한 몇몇 유저들만이 사용하는 시스템구성이었습니다.

그러던것이 하드용량의 증가와 함께 HDD의 가격이 하락되는 시점에서 알려질듯 하다가... SSD의 출현이 그 앞을 가로 막고 있지 않나 합니다.

SSD의 레이드 구성~!!!

HDD로 도미노 게임 해보는것 다음으로 꼭 구성해보고 보고 싶은 희망이 있지만... 주머니 사정상 내년을 기약해야 될듯 합니다. 일단 단일 SSD의 성능 만으로도 충분히 만족하니까요 ^^ (일단 케이스가 먼저~ ^^)

RAID ( Redundant Array of Inexpensive Disks 또는 Redundant Array of Independent Disks )

RAID ( Redundant Array of Inexpensive Disks 또는 Redundant Array of Independent Disks )1988년 버클리 대학의 3명의 과학자가 제안한 이론으로 그 당시에는 하드디스크의 용량이 제한적이었고, 함부로 사용하는 이도 드물 정도로 값도 비쌌기 때문에 보다 저렴하며 용량이 적고, 성능이 낮은 하드디스크를 묶어 중복 구성함으로써, 성능이 좋은 고가의 대용량 하드디스크 장비와 겨뤄 손색이 없도록 하는 것이 주목적이었습니다.

그러나 그들이 열심히 RAID를 연구하는 동안 Storage 기술의 발전으로 용량대비 가격이 지속적으로 하락하였으므로 애초 주목적이었던 가격적인 면보다는 데이터의 안정성과 에러 보정, 그리고 하드디스크의 장애에 의한 데이터의 손실을 막기 위한 측면이 강조되었고, RAID의 의미는'Inexpensive'에서 'Independent'로 의미가 바뀌게 되었습니다.

단순히 구성으로만 보자면 지금 많이들 사용하는partition의 반대 비슷한 개념정도 됩니다.

파티션이 하나의 물리적인 드라이브를 여러개의 논리적 드라이브로 분할한것 이라면.. 레이드는 여러개의 물리적 드라이브를 하나의 논리적 드라이브로 묶는 방식 입니다.

보다 정확한 파티션의 반대 개념은 단순히 구성을 묶기만 하는 JBOD (Just a Bunch Of Disks 또는Just a Bunch Of Drives) 가 더 가까울듯 합니다. 이것은 여러 개의 물리 드라이브를 논리적인 하나의 커다란 드라이브로 결합해주는 것일 뿐, 각각의 드라이브를 독립적으로 사용하는 것에 비해 어떠한 장점도 없으니까요.

RAID 시스템은 동일한 데이터를 여러 개의 디스크에 중복 저장하면서도, 운영체계에는 하나의 단일 디스크로 인식시킴으로써, 내고장성의 증가와 데이터 접근 효율성을 높여주는 장점이 있습니다.레이드는 하드디스크가 묶이는 방식에 따라 레벨로 나뉘어지며 효율성과 안정성을 고려하여

레벨을 결정하게 됩니다.

초기 RAID는 6단계의 레벨로 나뉘어졌으나,

현재에는 보다 많은 RAID 레벨이 존재하고 있습니다. 레벨은 성능순이나 중요도순으로 숫자가 정해진 것은 아니므로, RAID 레벨 1이 RAID 레벨 0보다 우수하다거나 하는 등으로 단정지어서는 안됩니다.

RAID Level 0 ( 레이드 0 ) : 필요 드라이브 최소 2개이상

스트리핑 구성시 충족요건은..같은 모델의 하드디스크와 같은 용량이어야 한다는 전제 조건이 있습니다.

레이드 0 구성시 중요데이터는 반드시 Back-up 하셔야 합니다.

레벨 0은 RAID의 가장 기본적인 구현방식으로 Striping(스트라이핑)이라고 합니다.

이것은 하나의 데이터를 여러 드라이브에 분산 저장을 함으로써 빠른 입출력을 가능하게 합니다.

1부터 100까지의 숫자로 이루어진 데이터가 있다면

이것을 1부터 100까지 순서대로 읽게 되는 상황이 일반적인 하드디스크의 구성이고

2개의 하드 디스크로 레벨0 을 구성하면 하나는 1~50 까지만 읽고

다른 하나는 51부터 100까지만 읽고 저장하기 때문에 그 속도는 2배가 됩니다.

즉 3개로 구성되면 속도는 3배가 되고 10개로 구성되면 그 속도는 1/10 로 줄어 들게 됩니다.

제글의 부족한 부분을 댓글로 채워주신 분의 의견이라 첨부합니다.

위에서 설명하셨듯이 하나의 데이터는 Stripe(스트라이프) 기술을 이용해서

여러개의 같은, 일정한 크기로 쪼개집니다. 그리고 이 쪼개진 하나하나의 조각을

Stripe Unit(스트라이프 유닛)이라고 합니다.

다시한번 말하자면, 1에서부터 100까지의 숫자로 이루어진 데이터가 있습니다.

이 데이터는 스트라이핑에 따라 두 개의 스트라이프 유닛으로 나뉘는데

1에서부터 50까지, 51부터 100까지 각각 두개의 스트라이프 유닛에 나뉘어 들어갑니다.

여기까지 이해하셨으면 그 다음부터는 Rapter님의 설명을 그대로 따라가셔도 좋습니다. 나뉜 두개의 스트라이프는 두개의 디스크에 차례로 들어가는 거죠.

레벨 0은 분산 저장에만 초점이 맞춰져 있어 하드디스크의 속도 향상에는 무척 도움이 되지만,

Striping(스트라이핑) 되어 있는 하드디스크 중 1개만 장애를 일으키더라도 데이터를 모두 유실할

위험성이 있습니다.

예 ) "어린이" 라는 단어를 2개의 드라이브(하드 디스크)로 구성된 Raid 0 에 저장한다면

한개의 드라이브는 "ㅇ , ㄹ, ㄴ, ㅇ" 라는 자음만 저장하고

다른 하나는 " ㅓ, ㅣ, ㅣ " 이런 모음만 저장합니다.

따라서 저장하거나 불러오는 속도는 빠르지만 하나의 디스크에서 에러가 발생하면...

완전한 데이터를 불러오지 못하게 되는 것입니다.

300GB 두개로 레이드0 을 구성하면 600GB의 단일 드라이브로 나타나고 성능 또한 2배이지만

하나의 디스크에서 손실이 발생하면 둘다 사용하지 못하게 됩니다. 안전성이 낮은 구성입니다.

RAID Level 1 ( 레이드 1 ) : 필요 드라이브 최소 2개이상

레벨 1은 2개의 하드디스크가 사용되며, 하나의 하드디스크에 기록되는 모든 데이터가 나머지 하나의 하드디스크에 고스란히 복사되는 방법으로 저장하게 됩니다. 두 개의 하드디스크에는 한치의 오차도 없이 똑같은 데이터가 저장이 되기 때문에 Mirroring(미러링)이라고 합니다. 이 경우 2개의 하드디스크 중 1개가 장애를 일으키더라도 남은 1개의 데이터는 장애를 일으킨 하드디스크의 데이터와 똑같기 때문에 안정성 측면에서 상당히 우수한 구성입니다.

읽기에서는 성능의 향상이 있으나, 쓰기에서의 속도 향상은 별반 차이가 없고, 전체 공간의 50%만 이용할 수 있다는 문제점이 있습니다. 때문에 매우 중요한 파일을 백업 받을 일이 없는 개인 사용자의 경우 하드디스크 두 개로 한 개 용량만 사용해야 한다는 단점이 있습니다.

두 레벨의 용량의 효율성을 비교하면...

레벨0은 속도와 용량의 효율성은 높으나 안정성이 떨어지고...

레벨1은 안전성은 뛰어나나 속도와 효율성이 떨어집니다.

그래서 나온것이 Raid 3과 4 인데...

RAID Level 2 는 기록용 드라이브와 테이터 복구용 드라이브를 별도로 두는데..

4개 하드 디스크에 기록하기 위해서는 3개의 부가 데이터를 기록해야 되기 때문에 효율성 측면에서

거의 사용하지는 않습니다. RAID 2는 RAID 0처럼 스트라이핑 방식이지만 에러 체크와 수정을 할 수 있도록 Hamming Code를 사용하고 있는 것이 특징입니다. 레벨 4가 나오면거 거의 사용하지 않는 기술입니다. 레벨2의 설명은 요정도 패스 ^^

RAID Level 3, 4 ( 레이드 3, 4 ) : 필요 드라이브 최소 3개이상

RAID 3, RAID 4는 RAID 0, 1의 문제점을 보완하기 위한 방식으로 3, 4로 나뉘긴 하지만 RAID 구성 방식은 거의 같습니다. RAID 3,4는 기본적으로 RAID 0과 같은 스트라이핑(Striping) 구성을 하고 있어 성능을 보완하고 디스크 용량을 온전히 사용할 수 있게 해주는데, 여기에 추가로에러 체크 및 수정을 위해서 패리티(Parity) 정보를 별도의 디스크에 따로 저장하게 합니다.

Raid 3 과 Raid 4의 차이점은

Raid 3은 Byte단위로 데이터를 저장하는 반면 Raid 4는 Block단위로 저장합니다.

Block단위로 저장을 할 경우 작은 파일의 경우는 한번의 작업으로 데이터를 읽을 수 있기 때문에 성능상의 장점이 있습니다. 레벨 3은 동기화를 거처야 하기 때문에 3보다는 레벨 4를 많이 사용합니다.

데이터가 저장되어 있는 드라이브에 장애가 발생되었을 경우에는 패리티 정보를 이용하여 복구할 수 있으나, 정작 패리티 정보가 저장되어 있는 하드디스크에 장애가 발생하면 복구가 불가능하다는 단점이 있습니다. 또한 패리티 하드디스크에 병목현상이 생겨 속도가 저하될 수 도 있습니다.

레이드 0의 구성에 백업용 드라이브 하나 더 달아서 안정성을 확보한 구성입니다.

그러나 레벨 3과 레벨 4의 단점을 보완한 레벨 5의 등장으로 저 역시 한번도 구성 해본적은 없습니다.

이쯤 보시면 이제 Raid에 대해서 대충 감이 오시죠?

Raid Level 0 의 Striping(스트라이핑) : 데이터를 쪼개서 분산 저장 해서 속도향상

Raid Level 1 의 Mirroring ( 미러링 ) : 안전성을 중요시 하지만 드라이브 용량 이용의 비효율성

Raid Level 3 의 Parity ( 패리티 ) : 데이터 오류 체크 기술로 레벨0읠 불안전성을 보완

이 3가지를 어떻게 구성하는냐에 따라서 Raid의 레벨이 결정됩니다.

이제 Raid 5 와 Raid 6 그리고 이들의 복합 구성인

Raid 0 +1 또는 1+0 , Raid 5 + 0, Raid 5 + 1 에 관해서는 다음편에... ^^

Raid 레벨 0~4까지 다루었습니다.

해당내용은 아래의 링크를 아래 참고 하세요.

레이드 ( RAID ) 의 레벨과 구성 ( 1부 : Raid Level 0,1,2,3,4 )

간단하게 정리하자면

Raid Level 0 인 Striping(스트라이핑)은

데이터를 쪼개서 저장하는

즉, 분산 저장 해서 속도향상을 위한 레벨이고

Raid Level 1 의 Mirroring ( 미러링 )은

안전성을 좋지만 드라이브 용량 이용의 비효율성이 있습니다

Raid Level 3,4 는 Parity ( 패리티 : 데이터 오류 체크 기술)로 레벨0의 불안전성을 보완한것입니다.

이제 가장 많이 사용하는

Raid Level 5 와 Level 6 복합구성인 01, 50, 60 등에 관해서 말하겠습니다.

RAID Level 5 ( 레이드 5 ) : 필요 드라이브 최소 3개이상

레벨 5는 레벨 3과 레벨 4의 단점을 보완한 방식으로, 패리티 정보의 저장을 전담하는 하드디스크 대신 모든 하드디스크에 패리티 정보를 분산 저장합니다. 이 방식은 쓰기(Write)에는 패리티 정보가 분산되어

저장되기 때문에 Level 3, 4의 단점이었던 병목을 줄여주지만, 읽기(Read)에서는 사방에 흩어져 있는

패리티 정보를 갱신하며 읽게 되기 때문에 성능 저하가 생길 수밖에 없습니다.

이러한 단점 역시 컨트롤러에 지능형 캐쉬를 내장하여 속도저하를 최소화시키는 역할을 하고 있습니다.

성능면에서 Raid 0 보다 떨어지지만 성능, 안정성, 용량 3 부분을 고려한 형태입니다.

하나의 드라이브가 고장날 경우 다른 드라이브에 별도로 저장된 패리티( Parity ) 정보를 정보를 통해서

복구하고 손상된 드라이브의 패리티 ( Parity ) 정보는 나머지 하드에 있는덷 테이터를 토대로 다시 작성할 수 있습니다. 그러나 별도의 패리티 정보를 저장하는 작업을 해야 하기 때문에 RAID Level 1 보다는

쓰기 성능이 떨어집니다.

가끔 전화와서

" 고객님~!" " 계란을 한바구니에 담지마라~!! 그러면서~ 좋은 상품이 있어서~~."

요러 면서 광고 시작하죠?

이 멘트가 적용된 레이드 구성입니다. 각각의 하드에 패리티 정보를 분산 시킨거죠 ^^

RAID 3, 4와 달리 패리티 정보가 저장된 디스크가 따로 없어 패리티 디스크 고장과 같은 문제에서

자유롭고 실제 서버/워크스테이션에서 가장 많이 사용되는 방식입니다.

RAID Level 6 ( 레이드 6 ) : 필요 드라이브 최소 4개이상

레벨 6은 RAID 5와 같은 개념이지만 다른 드라이브들 간에 분포되어 있는 2차 패리티 정보를 넣어 2개의 하드에 문제가 생겨도 데이터를 복구할 수 있습니다. RAID 5보다 더욱 데이터 안정성을 고려하는 시스템에서 사용합니다.

하드를 스트라이핑으로 묶었기 때문에 RAID 0+1이나 RAID 10(1+0)보다 성능은 더 높고 신뢰성도 우수 하지만 패리티 정보를 2중으로 저장하면서 읽기 성능은 RAID 5와 비슷하지만 쓰기 작업 구현이 아주 복잡해서 일반적으로 잘 사용하지 않습니다.

RAID Level 0+1 / 1+0 (레이드 01 / 10 ) : 필요 드라이브 최소 4개

간단히 말하자면 레이드 레벨 0과 레벨 1의 복합 구성입니다.

레벨 0의 Striping과 레벨 1의 Mirroring의 기능이 합쳐진 것으로, 분산 저장을 통한 성능 향상을 꾀할 수 있으면서 데이터의 안정성 또한 보장받을 수 있습니다. 때문에 속도 및 안정성 두 마리의 토끼를 다 잡은 듯 보이지만, 여전히 전체 용량의 50%만 사용할 수 있는 것은 변함이 없으며, 비용이 많이 든다는 문제점이 있습니다.

01과 10의 차이는 어느 쪽을 먼저 구성하느냐의 차이입니다.

4개의 드라이브로 구성한다면 위의 이미지 처럼 그 차이는 없습니다.

그러나 6개의 드라이브로 구성한다면 달라지게 됩니다.(아래 이미지 참고)

드라이브가 6개일때 01의 구성은 3:3 으로 구성되지만

10의 구성은 2:2:2 로 구성되게 됩니다.

드라이브가 6개일때...

RAID 0+1은 RAID 0으로 구성된 드라이브들을

최종적으로 RAID 1로 묶는 것이라 각각 3개씩 하드 가 나눠지며,

RAID 1+0은 2개씩 RAID 1으로 묶여있는 하드들이 RAID 0으로 구성됩니다.

RAID 0+1의 경우 1개의 하드만 고장나서

복구해도 다른 RAID 0 구성에서 나머지 하드까지 데이터 전체를 복구해야 하지만,

RAID 1+0으로 만든 시스템은

고장난 하드가 하드 1개라고 하면 미러링으로 묶인 하드를 통해 데이터만 복구하면 되므로

실제로 운용하는데는 RAID 1+0 이 훨씬 유리합니다.

이외에 Raid 51 / 15 , Raid 05 / 50 , Raid 60 이나 Raid100 등 역시 기존의 레벨의 복합적 구성입니다.

레벨 0 이 들어가면 성능의 향상을 기대할수 있으나 안정성은 불안하게 됩니다.

레벨 1 이 들어 가면 안전성을 확복할수 있으나 용량의 감소 또한 감수 해야 됩니다.

레벨 5나 6의 구성에 최소 3~4개의 드라이이브가 소모되기 때문에

이들의 복합적인 구성은 최소 6개 이상의 드라이가 있어야 가능한 구성입니다.

한마디로 돈 많이 들어간다는 거죠. ^^

마지막으로 나름대로 정리해본 레이드 레벨(RAID Level)에 따른 정리 표 입니다.

< 이미지를 클릭하시면 크게 보실수 있습니다. Image Click~!! >

랜덤 읽기/ 쓰기의 성능의 향상은 체감속도의 향상과 같습니다. 프로그램을 런칭하는 속도가 랜덤 엑세스의 성능과 비례한다고 보시면 됩니다. 그리고 순차 읽기 / 쓰기는 영화파일과 같은 대용량의 파일을 이동할때의 성능 이라고 생각하시면 됩니다. ~ ^^

레벨 5 이상의 복합 구성은(50, 60) 거의 서버용이기 때문에 비용문제와 함께 거의 사용하지 않습니다.

메인보드에서 레이드 5레벨을 지원한다면 5를 추천하지만 일반적으로 많이 사용하는 것이 레이드 레벨 0 과 1의 복합 구성이 01 또는 10 입니다. 인텔의 H57칩셋 또는 P55 칩셋을 탑제한 메인보드는 레이드 5레벨까지 구성을 지원합니다. ~ ^^ 구입하실때 참고하세요.

출처 http://smsinfo.tistory.com/176

vgdisplay의 alternate Link

아마 님의 Array와 서버가 연결된 것을 보면 2개의 I/O cards에서 Array의 controllers에 각각 연결되어 있을 겁니다..

/dev/dsk/c3t0d1 와 dev/dsk/c7t1d1 는 실제 같은 디스크 영역(LUN)을 나타내며 c3t0d1이 primary path로 실제 I/O가 발생하는 경로입니다..

만약 c3t0d1의 경로를 가진 I/0 card나 array controller에 하드웨어 장애가 발생할 경우 대체 경로(path)인 c7t1d1의 경로를 통해서 I/O가 이루어집니다..

HP UX LVM

PV 생성, VG 생성, LV 생성, MOUNT

mkdir /dev/vg10

mknod /dev/vg10/group c 64 0x100000

vgcreate -s 64 /dev/vg10 /dev/dsk/c5t0d0 /dev/dsk/c7t0d0 ... ...

lvcreate -l [PE 사이즈] -n collect vg10

newfs -F vxfs -o largefiles /dev/vg10/collect

시스템이 Online JFS Product 를 지원할 경우 umount없이 fsadm 명령으로 파일 시스템 확장 가능

#fsadm -F vxfs -b 32M /collect

시스템이 Online JFS Product 를 지원할 경우 umount없이 fsadm 명령으로 파일 시스템 확장 가능

#fsadm -F vxfs -b 32M /collect

mkdir /collect

mount /dev/vg10/collect /collect

===========================================================================

VG에 DISK 추가 -> LV 확장

umount /collect

pvcreate -f /dev/rdsk/c5t0d2

pvcreate -f /dev/rdsk/c7t0d2

vgextend /dev/vg10 /dev/dsk/c5t0d2 /dev/dsk/c7t0d2

lvextend -l [PE 사이즈 늘려줌] /dev/vg10/collect

newfs -F vxfs -o largefiles /dev/vg10/rcollect

newfs -F vxfs -o largefiles /dev/vg10/rcollect

mount /dev/vg10/collect /collect

===========================================================================

LV 축소

lvreduce -l [PE사이즈] /dev/vg10/collect

newfs -F vxfs -o largefiles /dev/vg10/rcollect

mount /dev/vg10/collect /collect

===========================================================================

LV 삭제

umount 후

lvremove /dev/vg10/collect

VG 삭제

vgreduce /dev/vg10 /dev/dsk/cXtXdX

vgremove하기 전 디스크는 최소 한개는 남아 있어야함.

vgremove /dev/vg10

PV 삭제

pvremove /dev/rdsk/cXtXdX

===========================================================================

VG삭제 안될시

vgcfgrestore -n /dev/vg10 /dev/rdsk/cXtXdX

vgcfgrestore -n /dev/vg10 /dev/rdsk/cXtXd1

===========================================================================

vgchange -a n vg10

vgexport -v m vg10.map /dev/vg10

mkdir /dev/vg10

mknod /dev/vg10/group c 64 0x100000

vgimport -v -m vg10.map /de/vg10 /dev/dsk/cXtXdX

vgchange -a y /dev/vg10

mount /dev/vg10/collect /collect

===========================================================================

LV 축소

umount /collect

lvreduce -l [PE사이즈] /dev/vg10/collect

newfs -F vxfs -o largefiles /dev/vg10/rcollect

mount /dev/vg10/collect /collect

===========================================================================

LV 삭제

umount 후

lvremove /dev/vg10/collect

VG 삭제

vgreduce /dev/vg10 /dev/dsk/cXtXdX

vgremove하기 전 디스크는 최소 한개는 남아 있어야함.

vgremove /dev/vg10

PV 삭제

pvremove /dev/rdsk/cXtXdX

===========================================================================

VG삭제 안될시

vgcfgrestore -n /dev/vg10 /dev/rdsk/cXtXdX

vgcfgrestore -n /dev/vg10 /dev/rdsk/cXtXd1

===========================================================================

vgexport -v m vg10.map /dev/vg10

mkdir /dev/vg10

mknod /dev/vg10/group c 64 0x100000

vgimport -v -m vg10.map /de/vg10 /dev/dsk/cXtXdX

vgchange -a y /dev/vg10

mount /dev/vg10/collect /collect

피드 구독하기:

덧글 (Atom)